Dentro de la historia reciente de procesadores Intel basados en arquitectura x86 podemos identificar dos grandes revoluciones que se han dejado notar por suponer cambios importantes a nivel interno, es decir, a nivel estructural.

Hablados de la generación Core 2 Duo, y por ende también los Core 2 Quad, y de Sandy Bridge,

que fue la sucesora de aquella y marcó un gran incremento a nivel de

rendimiento, tanto que todavía hoy CPUs como los Core i5 2500 o los Core

i7 2600 ofrecen un desempeño muy bueno.

Ahora que nos hemos puesto un poco en situación y sabemos exactamente

de qué tipo de cambios estamos hablando nos centramos en la noticia,

aunque de momento es sólo un rumor y por tanto debemos tomarla como tal.

Varías fuentes apuntan que el gigante del chip estaría preparando un cambio de arquitectura x86

que podría debutar en algún momento de 2020, es decir justo después del

lanzamiento de Tiger Lake, y que a diferencia de todos los saltos que

hemos visto actualmente no tendría retrocompatibilidad con las

anteriores, o estaría limitada.

Sí, eso son palabras mayores, pero permitiría a Intel empezar a soltar lastre

y dejar espacio en el encapsulado para introducir mejoras importantes

con las que iniciar una nueva etapa en la computación x86.

Desde luego sería un cambio enorme, tanto que no termino de verlo salvo que la emulación

pueda solucionar totalmente esa ausencia de retrocompatibilidad, ya que

las Streaming SIMD Extension (SSE) antiguas pueden ser emuladas en SSE

superiores.

Un rumor interesante, sin duda, pero muy a largo plazo, tanto que de momento sólo podemos esperar a ver cómo evoluciona todo esto.

Fuente:

http://www.muycomputer.com/2016/12/27/intel-arquitectura-x86-nueva/

I+D Proyecto placa lavadora

viernes, 30 de diciembre de 2016

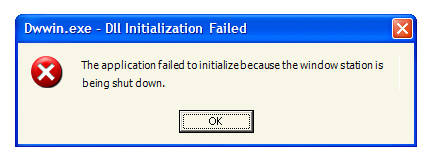

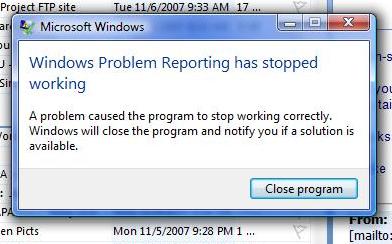

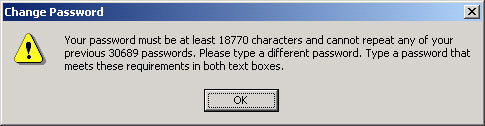

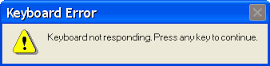

Los 10 mensajes de error más divertidos de Windows

Cualquier software tiene sus problemas y

los sistemas operativos de Microsoft no están exentos de ellos.

Exceptuando los más graves que terminan directamente en las pantallas

azules de la muerte o si son relativos al hardware, en reinicios o

apagados del equipo, el sistema devuelve mensajes de error advirtiendo del problema o con algún tipo de solución.

La mayoría de ellos proporcionan información acerca de los problemas reales del equipo, pero hay otro buen número que en la historia de Windows nos ha dejado sorprendidos porque son paradójicos, divertidos, molestos o simplemente estúpidos. Hoy revisamos algunos de ellos:

Fuente:

Fuente:

http://www.muycomputer.com/2016/12/27/mensajes-de-error-windows/

La mayoría de ellos proporcionan información acerca de los problemas reales del equipo, pero hay otro buen número que en la historia de Windows nos ha dejado sorprendidos porque son paradójicos, divertidos, molestos o simplemente estúpidos. Hoy revisamos algunos de ellos:

- La acción podría tardar un tiempo. Seguro que te has topado alguna vez con este tipo de mensajes cuando has copiado archivos con el explorador y el tiempo estimado era una eternidad. Como en el ejemplo, 127 años.

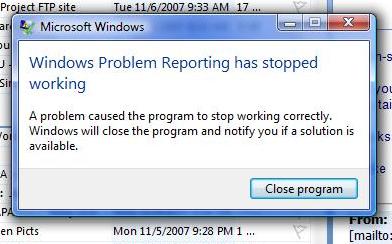

- Informe de error. Cada vez que un programa se bloquea en Windows, por lo general pide al usuario que envíe un informe de error para que Microsoft busque una solución exacta a su problema exacto. Sin embargo, ¿qué ocurre cuando el informe de errores se encuentra con un error?

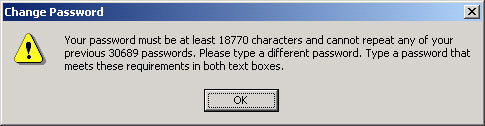

- Necesitas una contraseña más larga. Todos sabemos que la longitud de una contraseña es proporcional a su seguridad pero este mensaje de error que aparecía en Windows 2000 fue demasiado lejos y exigía no menos de 18.770 caracteres. Un mecanógrafo medio tardaría 45 minutos en introducirla.

- ¿Cuál es el problema? No hay nada más inútil que un mensaje de error sobre un potencial problema de seguridad. Aparecían mucho navegando mediante Internet Explorer y simplemente tocaba cerrarlo y seguir con lo que estábamos haciendo.

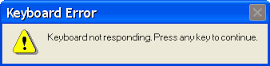

- Pulsa para continuar. Otro tipo de mensajes obliga a pulsar alguna tecla para continuar el proceso. Pero ¿qué ocurre si hay un problema y el teclado no responde?

- El problema es Windows Vista. Entre los grandes fiascos de los sistemas operativos de Microsoft se encuentra Vista. Algo que no escapa a los propios mensajes de error si bien muchos de ellos, no son causados por el mismo sistema y sí por drivers o aplicaciones de terceros.

- Falsa Alarma. Otro grupo de “mensajes de error” de Windows no son tales aunque su formato indique lo contrario. Un ejemplo de falso positivo es el siguiente:

- Algo ha ocurrido. No creas que Windows 10 está a salvo de estos mensajes de error. Aquí hay otro que tiene su gracia y se produce después de la actualización al último sistema operativo de Microsoft. Podrá ser útil internamente para desarrollo pero ¿qué significa para el usuario?

- No podemos cerrar el sistema. Los desarrolladores de software también crearon mensajes de error tan horribles que Microsoft tuvo que intervenir y crear una guía para crear mensajes más eficaces. El de la muestra es un ejemplo entre innecesario y molesto, que además impide el cierre del sistema si el usuario no lo cancela.

- Inserta un disco en el móvil. Los sistemas operativos móviles no están exentos de estos mensajes de error divertidos, cada vez más comunes a todas las plataformas ante su mayor integración. Como éste, que en Windows Phone, pide que insertes el disco de instalación de Windows.

Fuente:

Fuente:http://www.muycomputer.com/2016/12/27/mensajes-de-error-windows/

Bandai Namco quiere usar IA avanzada para crear juegos más difíciles

La publicadora de la conocida y querida franquicia Dark Souls ha llevado a cabo una inversión en una startup japonesa llamada Heroz que se dedica a la inteligencia artificial (IA),

una tecnología que Bandai Namco podría integrar en los juegos que

publica para hacer que tengan una mayor dificultad, entre otras cosas.

No sólo hablamos de conseguir una tecnología que permita incrementar la dificultad de los juegos, sino que también podría contribuir a que la misma se ajuste mejor a las propias capacidades del jugador, haciendo que evolucione al mismo tiempo que él.

Otra de las grandes posibilidades de esta tecnología sería la creación de personajes que presenten un comportamiento más realista y humano, e incluso podría servir como medio de comprobación y detección de errores en los juegos antes de su lanzamiento final.

Como vemos la inversión se entiende perfectamente y tiene un valor claro para Bandai Namco, sobre todo por que Heroz ya ha demostrado de lo que es capaz con la creación de algoritmos que han sido capaces de derrotar a jugadores profesionales en partidas de shōgi, el ajedrez japonés.

No ha trascendido la cantidad de dinero que han invertido, pero los medios hablan de “una cantidad pequeña”, que en cualquier caso debería ser suficiente para permitir a Bandai Namco acceder a la tecnología de Heroz.

¿Os imagináis un Dark Souls donde ese jefe que nos ha matado diez veces se adapte a nosotros para evitar que le cojamos el truco? Pues sería posible gracias a la inteligencia artificial avanzada y al aprendizaje profundo.

Fuente:

http://www.muycomputer.com/2016/12/27/bandai-namco-ia-avanzada/

No sólo hablamos de conseguir una tecnología que permita incrementar la dificultad de los juegos, sino que también podría contribuir a que la misma se ajuste mejor a las propias capacidades del jugador, haciendo que evolucione al mismo tiempo que él.

Otra de las grandes posibilidades de esta tecnología sería la creación de personajes que presenten un comportamiento más realista y humano, e incluso podría servir como medio de comprobación y detección de errores en los juegos antes de su lanzamiento final.

Como vemos la inversión se entiende perfectamente y tiene un valor claro para Bandai Namco, sobre todo por que Heroz ya ha demostrado de lo que es capaz con la creación de algoritmos que han sido capaces de derrotar a jugadores profesionales en partidas de shōgi, el ajedrez japonés.

No ha trascendido la cantidad de dinero que han invertido, pero los medios hablan de “una cantidad pequeña”, que en cualquier caso debería ser suficiente para permitir a Bandai Namco acceder a la tecnología de Heroz.

¿Os imagináis un Dark Souls donde ese jefe que nos ha matado diez veces se adapte a nosotros para evitar que le cojamos el truco? Pues sería posible gracias a la inteligencia artificial avanzada y al aprendizaje profundo.

Fuente:

http://www.muycomputer.com/2016/12/27/bandai-namco-ia-avanzada/

El ransomware evolucionará a lo largo del próximo año

No hay duda, el ransomware se ha convertido en una de las amenazas de seguridad más importantes y más graves que existen actualmente, y no sólo por su alta capacidad destructiva, sino también por su enorme popularidad.

Como sabéis muchos de vosotros un ransomware actúa cifrando archivos concretos de nuestras unidades de almacenamiento y acto seguido pide un rescate, que normalmente suele ser el pago de una determinada cantidad de dinero a través de Bitcoin.

La cifra puede variar mucho en función del tipo de ransomware y también de la persona que sufra la infección, ya que hay casos que van desde unos pocos cientos de dolares hasta otros que llegan a alcanzar las cinco cifras.

El caso es que esta amenaza irá a peor, y según el experto Corey Nachreiner, CTO de WatchGuard Technologies, a partir de 2017 veremos ransomworms, es decir, tendrán las mismas propiedades que los virus de tipo gusano.

Esto quiere decir que una vez que infecten un equipo intentarán extenderse a tantos otros como les sea posible, algo que puede ser especialmente grave en el caso de empresas que tienen configurados numerosos equipos en red.

Un ransomworm que se cuele en una empresa de ese tipo podría sembrar el caos y llegar a pedir un rescate millonario por los datos de todos los equipos infectados, un hecho que de nuevo pone de relieve lo que ya hemos dicho en ocasiones anteriores, y es que la alta rentabilidad que presentan estas amenazas se mantiene como su principal motor.

Fuente:

http://www.muycomputer.com/2016/12/28/ransomware-evolucionara-proximo-ano/

Como sabéis muchos de vosotros un ransomware actúa cifrando archivos concretos de nuestras unidades de almacenamiento y acto seguido pide un rescate, que normalmente suele ser el pago de una determinada cantidad de dinero a través de Bitcoin.

La cifra puede variar mucho en función del tipo de ransomware y también de la persona que sufra la infección, ya que hay casos que van desde unos pocos cientos de dolares hasta otros que llegan a alcanzar las cinco cifras.

El caso es que esta amenaza irá a peor, y según el experto Corey Nachreiner, CTO de WatchGuard Technologies, a partir de 2017 veremos ransomworms, es decir, tendrán las mismas propiedades que los virus de tipo gusano.

Esto quiere decir que una vez que infecten un equipo intentarán extenderse a tantos otros como les sea posible, algo que puede ser especialmente grave en el caso de empresas que tienen configurados numerosos equipos en red.

Un ransomworm que se cuele en una empresa de ese tipo podría sembrar el caos y llegar a pedir un rescate millonario por los datos de todos los equipos infectados, un hecho que de nuevo pone de relieve lo que ya hemos dicho en ocasiones anteriores, y es que la alta rentabilidad que presentan estas amenazas se mantiene como su principal motor.

Fuente:

http://www.muycomputer.com/2016/12/28/ransomware-evolucionara-proximo-ano/

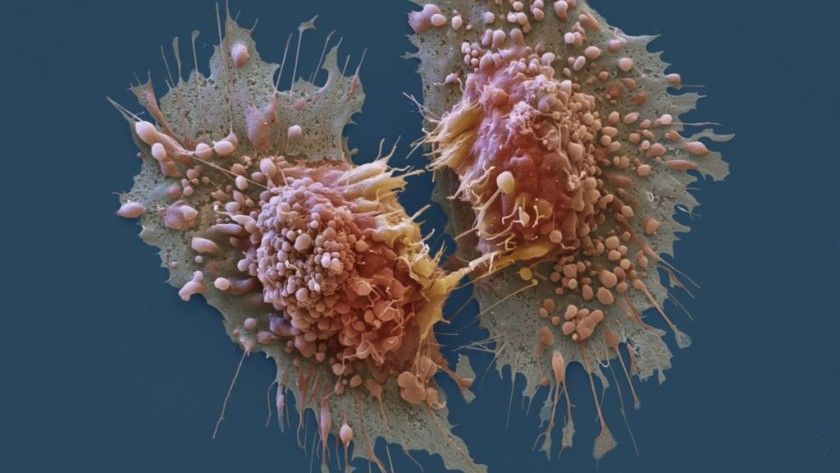

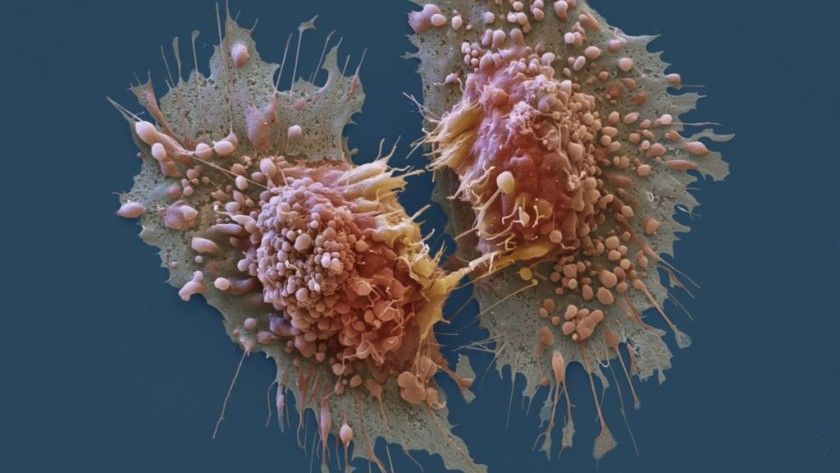

Crean nanodiscos para dar terapias personalizadas contra el cáncer

Investigadores de la Universidad de Míchigan han conseguido aplicar con éxito tratamientos personalizados contra el cáncer sobre ratones utilizando nanodiscos, que

están fabricados con lipoproteínas sintéticas de apenas 10nm. Gracias a

ellos pudieron activar de forma concreta el sistema inmunitario de los

roedores.

La clave detrás de este nuevo avance está obviamente en esos nanodiscos, que integran neoantígenos tumorales que son, en resumen, mutaciones concretas que se encuentran en en las células cancerosas y actúan como identificador.

Con esos nanodiscos se estimula y “educa” al sistema inmune del enfermo para que produzca los linfocitos T necesarios para acabar con esos neoantígenos, o dicho de otra forma, se enseña al sistema inmunitario a crear los recursos necesarios para acabar con el cáncer.

Como muchos de vosotros ya habréis podido adelantar estamos ante un tratamiento que funciona prácticamente como una vacuna, un detalle que se confirma cuando vemos que de hecho los ratones que fueron tratados con este sistema rechazaron sin problema las inyecciones de nuevas células cancerígenas hasta 70 días después.

Las primeras pruebas han mostrado resultados positivos al tratar tumores de piel y de colon. En ellas un 27% de los linfocitos T presentes en la sangre de los roedores atacaron de forma efectiva a las células tumorales, pero gracias al uso combinado de tecnologías de amplificación de respuesta de dichos leucocitos fue posible erradicar por completo los tumores, que además no volvieron a reproducirse.

Los investigadores ya han confirmado que el siguiente paso será probar el tratamiento en animales de mayor tamaño, y si todo sale bien no descartan llevarlo a seres humanos dentro de unos años.

Fuente:

http://www.muycomputer.com/2016/12/29/nanodiscos-terapias-personalizadas-cancer/

La clave detrás de este nuevo avance está obviamente en esos nanodiscos, que integran neoantígenos tumorales que son, en resumen, mutaciones concretas que se encuentran en en las células cancerosas y actúan como identificador.

Con esos nanodiscos se estimula y “educa” al sistema inmune del enfermo para que produzca los linfocitos T necesarios para acabar con esos neoantígenos, o dicho de otra forma, se enseña al sistema inmunitario a crear los recursos necesarios para acabar con el cáncer.

Como muchos de vosotros ya habréis podido adelantar estamos ante un tratamiento que funciona prácticamente como una vacuna, un detalle que se confirma cuando vemos que de hecho los ratones que fueron tratados con este sistema rechazaron sin problema las inyecciones de nuevas células cancerígenas hasta 70 días después.

Las primeras pruebas han mostrado resultados positivos al tratar tumores de piel y de colon. En ellas un 27% de los linfocitos T presentes en la sangre de los roedores atacaron de forma efectiva a las células tumorales, pero gracias al uso combinado de tecnologías de amplificación de respuesta de dichos leucocitos fue posible erradicar por completo los tumores, que además no volvieron a reproducirse.

Los investigadores ya han confirmado que el siguiente paso será probar el tratamiento en animales de mayor tamaño, y si todo sale bien no descartan llevarlo a seres humanos dentro de unos años.

Fuente:

http://www.muycomputer.com/2016/12/29/nanodiscos-terapias-personalizadas-cancer/

Diez momentos destacados de Ciencia en 2016

Continuamos repasando lo mejor que nos ha dejado el año y hoy toca un recopilatorio de Ciencia en 2016. Aunque no somos un medio especializado, es una sección que

mantenemos por la buena recepción entre nuestros lectores y su conexión

indudable con el sector tecnológico, en la que incluimos de todo un

poco, especialmente física, biología, investigación médica o exploración

espacial.

Intentamos resumir lo más interesante, innovador o importante para el futuro que nos ha dejado el año en este apartado, porque sería imposible listar todo lo que hemos publicado y que puedes repasar en nuestra categoría de ciencia.

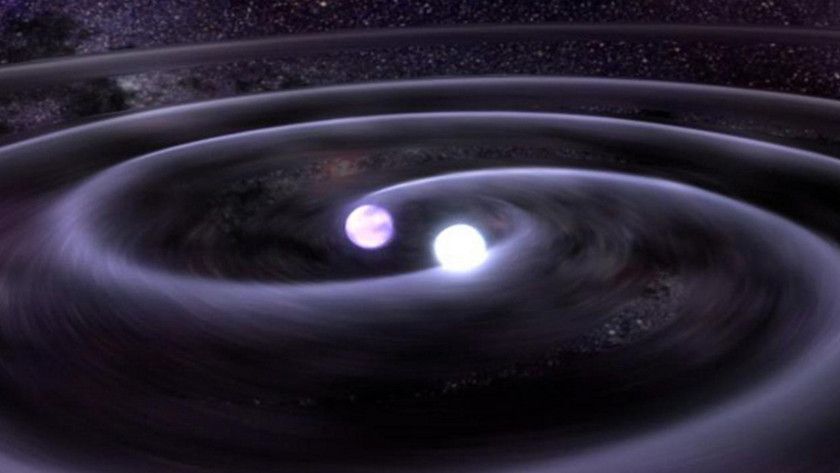

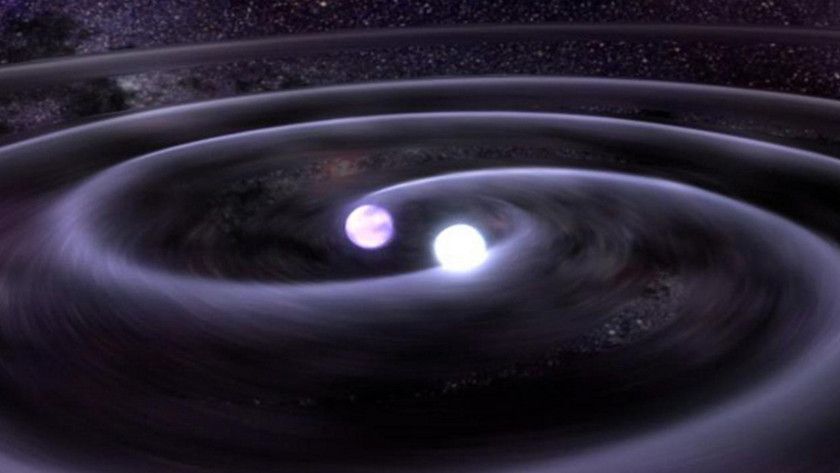

El director del observatorio LIGO confirmó en febrero la primera detección directa de las ondas gravitacionales predichas por Albert Einstein en su teoría de la relatividad general. 100 años han tardado físicos y astrónomos en confirmar estas fluctuaciones generadas en la curvatura del espacio-tiempo, producidas por un cuerpo masivo acelerado y se propagan como ondas similares a las que podemos apreciar cuando tiramos una piedra en un estanque de agua. Eso sí, a la velocidad de la luz.

La amplitud de las ondas gravitacionales es muy débil y por ello su detección directa es sumamente difícil. Cualquier objeto con masa debería producirlas pero solo los fenómenos más violentos como la explosión de una supernova, la rotación de una estrella de neutrones o los agujeros negros permiten registrarlas. De hecho, la onda detectada que ha llegado a la Tierra tiene una amplitud de onda inferior a la de un protón. Precisamente una colisión y fusión de dos agujeros negros, monstruos con una masa 36 veces superior a la de nuestro Sol, es el fenómeno que ha permitido la detección de las ondas gravitacionales.

Aunque se daban por seguras, hasta ahora solo se habían logrado evidencias indirectas de su existencia. De ahí la importancia de la primera detección directa registrada en el mes de septiembre por el Observatorio de interferometría láser (LIGO) y anunciada después de varios meses de revisiones de los datos. La detección también es importante porque los agujeros negros se han detectado directamente mediante su medición, a través de su gravedad, en lugar de medir el efecto que tienen sobre otra materia en el universo.

Algunos expertos aseguran que la evidencia directa de las ondas gravitacionales marcará el inicio de una nueva era de la astronomía. Una herramienta con la que estudiar todos los objetos astrofísicos que existen, la formación del Universo y sus leyes.

Seguramente a sus responsables les espera el Nobel. Al mayor científico del siglo XX, que teorizó sobre ellas (sin evidencias directas ni indirectas ni un aparato tan potente como el LIGO) como consecuencia inevitable de la teoría de la relatividad general, el premio es una larga vida en la eternidad.

El virus del Ébola es uno de los filovirus más temibles del mundo, ya que como sabemos provoca una enfermedad muy grave que provoca fiebres hemorrágicas y además es altamente contagioso, por lo que su potencial para causar epidemias es elevado.

Para hacernos una idea de lo peligroso que resulta basta recordar que el último brote de Ébola provocó la muerte de unas 11.000 personas, y sembró el miedo a nivel internacional por las posibles consecuencias que tendrá una infección a nivel global, ya que no hay una vacuna que permita hacerle frente de forma eficaz.

Por suerte el duro trabajo de científicos y expertos ha dado su fruto, ya que finalmente ha sido posible crear una vacuna que en los primeros ensayos y pruebas ha demostrado tener un 100% de eficacia, el doble comparada con la que se había probado en 2015. Esto es muy importante, ya que el uso de vacunas como elemento de prevención podría evitar que se produzcan brotes tan graves como el que se inició en Guinea a finales de 2013 y que mantuvo en alerta a la Organización Mundial de la Salud hasta el primer trimestre de 2016.

La vacuna todavía no ha recibido la aprobación necesaria para que pueda empezar a utilizarse de forma definitiva, pero se espera que se cumplan todos los requisitos para ello en algún momento de 2018.

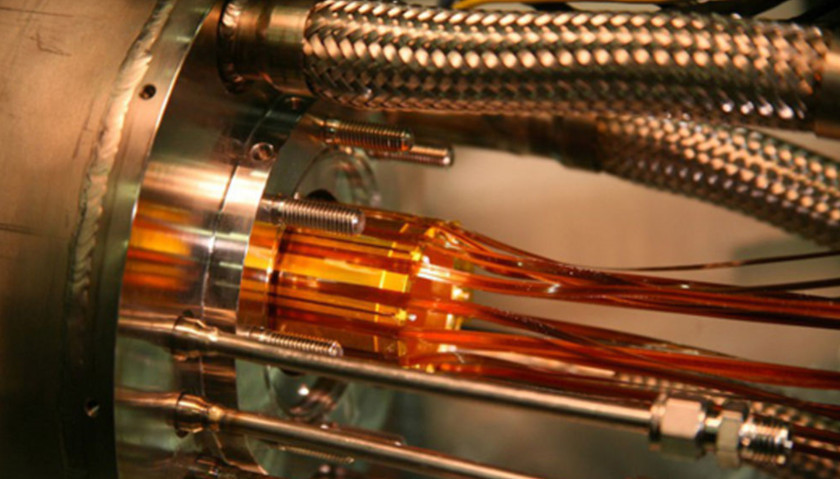

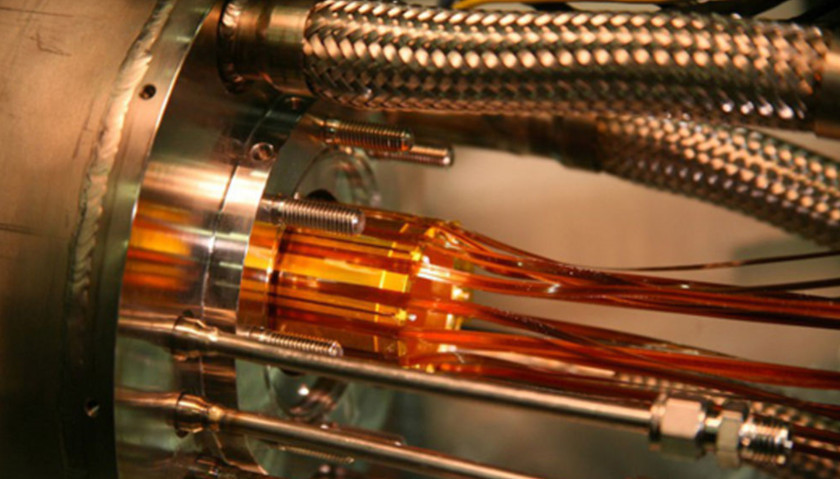

El grupo de investigación ALPHA del CERN, ha logrado medir la antimateria por primera vez en la historia. Un experimento pionero publicado en Nature que ha conseguido observar el espectro de luz de la antimateria, uno de los materiales más misteriosos del universo.

Los investigadores del CERN, el mayor laboratorio de investigación en física de partículas del mundo, han utilizado un láser para excitar las antipartículas (positrones y antiprotones) y comenzar a medir la estructura atómica de la antimateria, antihidrógeno en el experimento. El hidrógeno tiene un solo protón y un único electrón, por lo que es el átomo más simple y abundante para utilizar, aunque conseguir su contrapartida de antihidrógeno es sumamente difícil.

La antimateria suena como algo salido de la ciencia ficción. “La primera vez que oí hablar de la antimateria estaba viendo Star Trek , cuando era un niño”, explica Jeffrey Hangst, físico de la Universidad de Aarhus en Dinamarca y fundador del grupo de investigación ALPHA del CERN, que se dedica al estudio de la antimateria. Hangst explica que “lo que se escucha en la ciencia ficción sobre que la antimateria se aniquila con la materia normal es 100% verdad“, porque cada vez que la antimateria entra en contacto con la materia normal ambas desaparecen en un destello de luz y de ahí la dificultad de su estudio.

El experimento perseguía conocer si la materia y la antimateria verdaderamente obedecen a las mismas leyes de la física. “La medición del espectro del antihidrógeno con alta precisión ofrece una herramienta extraordinaria para probar si la materia se comporta de forma diferente de la antimateria”, explican los científicos.

Los resultados de la primera medición de la antimateria (antihidrógeno) no han mostrado diferencias con el hidrógeno (materia). Es solo un primer paso. El grupo de investigación ALPHA del CERN lleva trabajando en la antimateria desde hace 20 años.

El cáncer se mantiene como uno de los peores males que puede sufrir un ser humano, y no sólo porque los tratamientos actuales no siempre resultan efectivos, sino porque además los mismos son en ocasiones muy invasivos y porque su éxito depende de una detección temprana, cosa complicada dado que el cáncer es, por desgracia, un asesino silencioso.

Este año han sido varios los nuevos métodos presentados contra el cáncer. Un grupo de científicos canadienses ha desarrollado una nanopartícula capaz de cambiar de forma que permite marcar las células tumorales, haciendo posible que la quimioterapia se realice directamente sobre dichas células, sin afectar a las restantes células sanas presentes en el organismo. Esta especie de quimioterapia dirigida plantea importantes ventajas, ya que permitiría acabar con los terribles efectos secundarios que tiene el tratamiento en su estado actual, aunque todavía se encuentra en una fase temprana y tiene camino por recorrer antes de que empiece a ser aplicada en entornos reales.

Otro método ha sido propuesto por un grupo de científicos del UT de San Antonio y está especialmente indicado contra formaciones tumorales consideradas de difícil acceso, es decir, aquellas que se encuentran localizadas en lugares donde la cirugía es imposible o poco viable por implicar un gran riesgo para la vida del paciente.

La idea base detrás de este tratamiento es sencilla, se inyecta un compuesto de nitrobenzaldehído en el tumor y se espera que éste se difunda por el mismo. Posteriormente se aplica una luz ultravioleta sobre la masa tumoral, lo que hace que las células que lo forman adquieran un alto grado de acidez y acaben destruyéndose. De momento ha sido probado en ratones con una tasa de éxito fantástica, ya que el 95% de las células cancerígenas desaparecían tras la aplicación de este tratamiento, aunque se encuentra todavía en una fase muy temprana y su salto a humanos podría no ser igual de efectiva.

Por último, señalar los nuevos avances hacia la vacuna universal contra el cáncer, o la posibilidad de desarrollar una vacuna que nos haga inmunes a la enferemdad, es decir, que consiga que nuestro cuerpo reaccione y actúe desde el primer momento evitando que el cáncer llegue a desarrollarse e impida por tanto que pueda alcanzar su fase más peligrosa, la metástasis, en la que las células cancerígenas se extienden a otros tejidos y órganos y que acaba derivando en una muerte segura en poco tiempo.

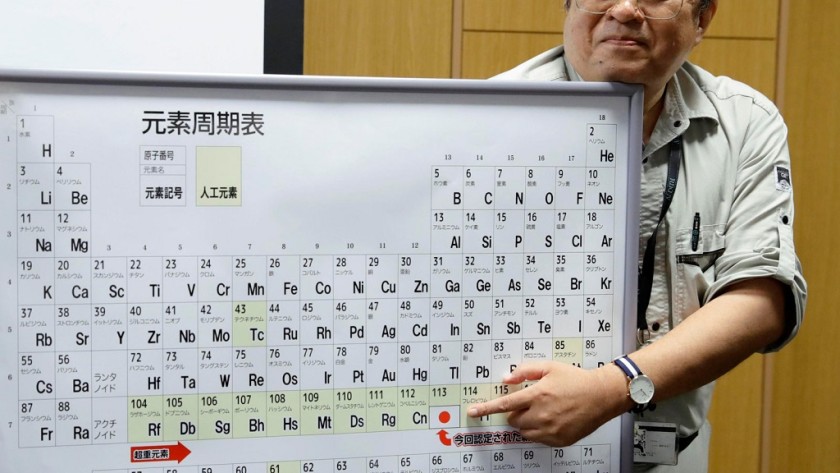

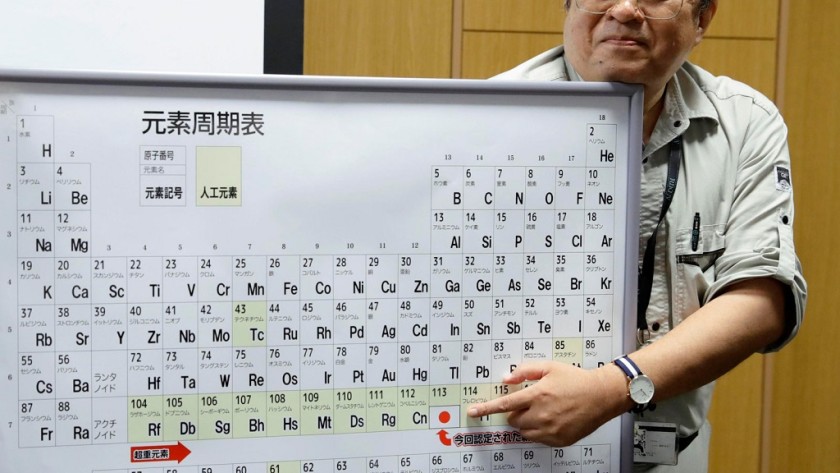

El pasado año se descubrieron cuatro nuevos elementos que ya tienen nombre definitivo, y que acaban de ser incluidos de manera oficial en la tabla periódica, con todo lo que ello supone para expertos, profesionales y estudiantes. Anteriormente conocidos por las numeraciones 113, 115, 117 y 118 desde hoy empezarán a ser identificados bajo los siguientes nombres:

Por otro lado también es importante destacar que la introducción de esos cuatro elementos no marca un punto de descanso para los expertos, que ya están trabajando para dar forma a los primeros elementos que serán integrados en la octava fila de la tabla periódica.

“No creo que podamos sobrevivir más de 1.000 años sin escapar de nuestro frágil planeta”, aseguró Stephen Hawking ante un millar de personas en el Festival Starmus que se celebra en Tenerife y La Palma, y que reunió a eminentes científicos (incluidos 11 premios Nobel) en una edición donde se rinde homenaje al físico teórico vivo más relevante del planeta.

Y de planetas habitables giró la charla de Hawking que insiste en la misma idea que lleva proclamando desde hace tres décadas: “la humanidad debe seguir viajando al espacio porque nuestro futuro no está en la Tierra”. Hawking es uno de los científicos detrás del proyecto Starshot, un programa que pretende enviar una flota de naves de exploración de inidicios de vida a Alfa Centauri, el sistema estelar más cercano al Sol (4,37 años luz).

El astrofísico celebró los avances en cosmología y los ambiciosos proyectos puestos en marcha en los últimos años, especialmente los destinados a conocer “de dónde venimos” nosotros y todo el Cosmos. “Nuestra imagen del Universo ha cambiado muchísimo en los últimos 50 años y me alegra mucho haber hecho una pequeña contribución”, explica.

“Los humanos no somos más que colecciones de partículas fundamentales de la naturaleza, y el hecho de que hayamos sido capaces de comprender gran parte de las leyes del Universo es un gran triunfo“, dijo Hawking, saludando la demostración de algunas de sus teorías sobre la formación del Universo o los agujeros negros, gracias a las misiones espaciales y la mejora en las mediciones.

Durante décadas el paciente cero del VIH ha sido considerado como el responsable de la expansión de una de las enfermedades más letales del mundo, al menos en sus inicios, ya que hoy gracias a los tratamientos con retrovirales se encuentra “bajo control”.

Sí, hoy es posible llevar una vida bastante normal y plena incluso aún estando afectado por el virus del sida, aunque es necesario recordar que hasta el surgimiento de dichos tratamientos esta enfermedad era sinónimo de muerte casi segura, y además bastante terrible, ya que debilita a los enfermos hasta dejarlos convertidos casi en una sombra de lo que fueron. Uno de los ejemplos más claros en este sentido lo tenemos en Freddie Mercury.

El caso es que hasta hoy se venía señalando al paciente cero como principal culpable del inicio del sida, un asistente de vuelo que habría mantenido relaciones sexuales con personas diferentes en todos los lugares por los que viajaba debido a su profesión, pero la ciencia finalmente lo ha exonerado por completo.

Las últimas investigaciones realizadas con secuencias de ARN han demostrado que las muestras del hasta ahora conocido como paciente cero no son las más antiguas que existen, sino que se sitúan en un punto posterior al de otras que nos llevan directamente a principios de los años setenta.

Esto quiere decir que el virus del sida ya estaba en Estados Unidos antes de la llegada del paciente cero, y que el mismo ha ido experimentando ciertas mutaciones desde entonces que han permitido diferenciar por etapas (o años) las distintas muestras que existen.

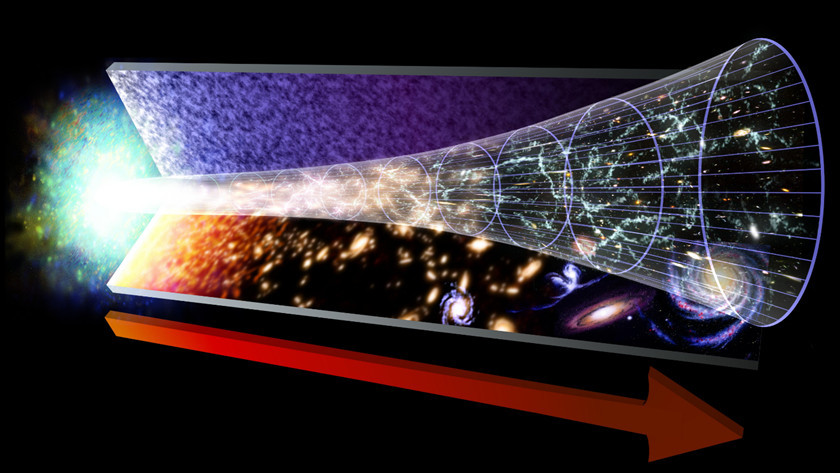

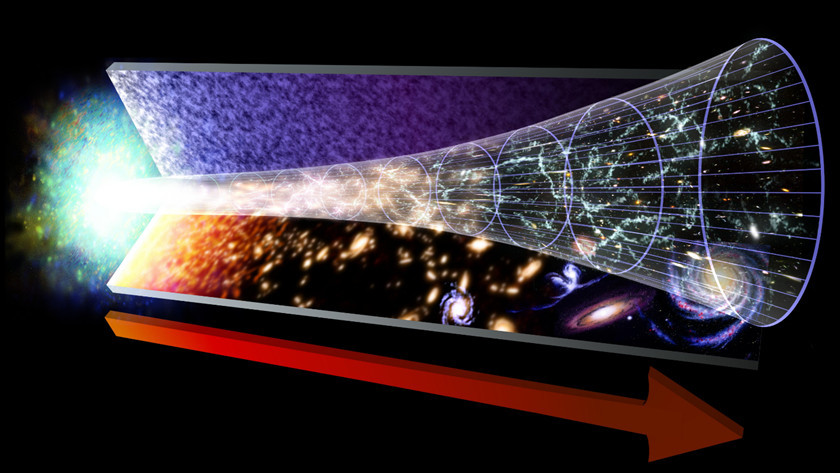

Un grupo de científicos detrás de la teoría de una velocidad de la luz variable y no constante como establecen leyes y teorías como la relatividad general de Einstein, dicen que cuentan con un método para probarlo.

Según la física de Einstein y la de otras teorías aceptadas para explicar el origen y expansión del universo, la velocidad de la luz es una constante en todos los marcos de referencia. Sin embargo, hace años que algunos físicos y cosmólogos la están cuestionando y apuestan por investigar en un nuevo marco teórico que explique el Universo y algunos fenómenos cosmológicos desconcertantes.

La constante de la velocidad de la luz puede sonar como el tipo de cosas intrascendentes que debaten los científicos, pero atreverse a contradecir el modelo de la física de Einstein tiene repercusiones en nuestra manera de entender el universo, tanto en la actualidad como en el pasado. Los que ponen en duda ese modelo, explican que la velocidad de la luz constante no es capaz de explicar por qué el universo hoy en día es tan inmenso, tan homogénea en su densidad y en gran medida uniforme en todas partes.

Con el fin de resolver la cuestión los científicos teorizan que la velocidad de la luz no es realmente constante. Al comienzo de la gran explosión, habría viajado más rápido. A medida que el universo se estableció y la expansión se ralentizó. también lo hizo la velocidad de la luz. Aunque todo esto es teoría, los científicos dicen haber encontrado una manera de probarlo. Los científicos han estudiado el mapa de microondas cósmico, que es la historia de la luz, del universo, y han utilizado un modelo para predecir un número específico de “índice espectral”.

Si dentro de unos años su predicción coincide con lo que realmente se observó en el índice, confirmarían su teoría como válida y Einstein estaría equivocado en su teoría con todo lo que ello implica porque toda la física teórica está basada en ella. El índice y el modelo será publicado Physical Review D y promete debate…

Lucy, una Australopitechus afarensis que vivió hace 3,18 millones de años y que estuvo considerada en su momento como nuestra “abuela más remota”, murió al caer de un árbol como la causa más probable, según concluye una investigación de la Universidad de Texas publicada en Nature.

Lucy no es cualquiera. Descubierta fosilizada en Etiopía en 1974, sorprendió ante lo completo que estaba su esqueleto, casi la mitad del total. El asombro de los paleontólogos llegó después cuando comprobaron que sus características físicas eran inusuales. Por un lado tenía piernas y brazos como un chimpancé, pero la pelvis ancha indicaba que caminaba erguida. Esta combinación de rasgos sugirió que su especie, Australopithecus afarensis, pudo ser un vínculo entre los humanos modernos y nuestros antepasados arborícolas y por ello, se consideró a Lucy como uno de los descubrimientos más importantes para entender la evolución humana.

Desde el hallazgo de este ancestro humano bípedo, se ha discutido si Lucy pasaba tiempo en los árboles y se ha intentado conocer la causa de su muerte. Y no ha sido fácil porque han tardado más de 40 años. Ahora parece desvelado el misterio: Lucy se cayó de un árbol desde una altura entre 10 a 14 metros, golpeando el suelo a más de 56 km por hora y no pudo superar las heridas. Hace más de tres millones de años Lucy hizo lo que cualquier humano hubiera hecho. Aterrizó con los pies pero cayó hacia adelante y entonces intentó frenar la caída estirando el brazo.

Es la conclusión de una investigación que utilizó una instalación Tomográfica de rayos X de Alta Resolución para crear un archivo digital de 35.000 imágenes. Los investigadores observaron una fractura inusual en el húmero que no se ve en los fósiles y que es una marca única cuando una mano toca el suelo en una caída, y el impacto se transmite a través del brazo.

Los investigadores creen que su doble capacidad como arborícola y terrestre, podrían haber debilitado su capacidad de trepar y moverse por los árboles porque es extremadamente extraño que -por ejemplo- un chimpancé se caiga y muera por esta causa. Lucy era distinta, nuestro ancestro más famoso fue un vínculo entre los humanos modernos y nuestros antepasados arborícolas. Las múltiples fracturas acabaron rápidamente con su vida cuando tenía entre 12 y 20 años de edad y hace más de tres millones de años.

Un grupo de investigadores asegura que la inmortalidad es un sueño, y no sólo eso, sino que han llegado a la conclusión de que lo máximo que podemos llegar a vivir en este planeta son 115 años. Esa esperanza de vida máxima se aplica a supuestos en los que la persona se cuida y hace todo lo necesario para mantenerse en buena forma, hábitos que sólo lleva a cabo de forma regular una parte muy pequeña de la población global.

Desde un punto de vista sensato y razonable debemos reconocer que con los medios, condiciones y estilos de vida actuales vivir 100 años ya es todo un logro, y hoy por hoy la idea de la inmortalidad es efectivamente un sueño, pero podría no serlo en un futuro. No podemos concretar una fecha, pero está claro que los avances que estamos haciendo en ingeniería genética irán dando poco a poco sus frutos, una realidad que unida a otros avances de tipo quirúrgico e incluso a la impresión en 3D de tejidos y órganos podría ayudarnos a conseguir tan ambiciosa meta.

A este respecto, este año se han presentado avances que en un futuro podría convertir el sueño de la inmortalidad en una realidad. Un grupo de científicos está dispuesto a sacar adelante un proyecto que ha generado una gran controversia: crear la humanidad perfecta y con ello extender la vida.

Dicho proyecto se conoce como HGP-Write y se centra en la creación de ADN desde cero, es decir, en la elaboración de genes sintéticos que podrían ser posteriormente implantados en seres humanos sin mayor problema y que tendrían un efecto terapéutico. Muy interesante, sin duda, pero sus posibilidades podrían ir más allá, ya que según los expertos no descartan que esta nueva técnica pueda servir incluso para crear nuevos órganos humanos totalmente funcionales.

Otra de las investigaciones interesantes en este sentido llegan de la primera terapia contra el envejecimiento. Según Elizabeth Parrish, CEO de Bioviva USA Inc, han sido los primeros en aplicar con éxito en humanos una terapia genética experimental contra el envejecimiento dividida en dos grandes versiones, una dirigida a frenar la pérdida de masa muscular y otra para luchar contra la reducción de células madre, ambas consecuencias directas de la edad.

La clave de todo está en los telómeros, segmentos cortos de ADN que se encuentran al final de cada cromosoma y que actúan amortiguando los efectos del paso del tiempo de forma permanente, aunque con los años se acaban desgastando de forma inevitable, lo que deriva en fallos y en un envejecimiento. Con esto en mente es más sencillo entender cómo funciona la terapia de Bioviva, revirtiendo el acortamiento de los telómeros, un proceso de momento afirman haber sido capaces de conseguir en un nivel máximo de 20 años.

Fuente:

http://www.muycomputer.com/2016/12/29/ciencia-en-2016/

Intentamos resumir lo más interesante, innovador o importante para el futuro que nos ha dejado el año en este apartado, porque sería imposible listar todo lo que hemos publicado y que puedes repasar en nuestra categoría de ciencia.

Primera evidencia directa de las ondas gravitacionales

El director del observatorio LIGO confirmó en febrero la primera detección directa de las ondas gravitacionales predichas por Albert Einstein en su teoría de la relatividad general. 100 años han tardado físicos y astrónomos en confirmar estas fluctuaciones generadas en la curvatura del espacio-tiempo, producidas por un cuerpo masivo acelerado y se propagan como ondas similares a las que podemos apreciar cuando tiramos una piedra en un estanque de agua. Eso sí, a la velocidad de la luz.

La amplitud de las ondas gravitacionales es muy débil y por ello su detección directa es sumamente difícil. Cualquier objeto con masa debería producirlas pero solo los fenómenos más violentos como la explosión de una supernova, la rotación de una estrella de neutrones o los agujeros negros permiten registrarlas. De hecho, la onda detectada que ha llegado a la Tierra tiene una amplitud de onda inferior a la de un protón. Precisamente una colisión y fusión de dos agujeros negros, monstruos con una masa 36 veces superior a la de nuestro Sol, es el fenómeno que ha permitido la detección de las ondas gravitacionales.

Aunque se daban por seguras, hasta ahora solo se habían logrado evidencias indirectas de su existencia. De ahí la importancia de la primera detección directa registrada en el mes de septiembre por el Observatorio de interferometría láser (LIGO) y anunciada después de varios meses de revisiones de los datos. La detección también es importante porque los agujeros negros se han detectado directamente mediante su medición, a través de su gravedad, en lugar de medir el efecto que tienen sobre otra materia en el universo.

Algunos expertos aseguran que la evidencia directa de las ondas gravitacionales marcará el inicio de una nueva era de la astronomía. Una herramienta con la que estudiar todos los objetos astrofísicos que existen, la formación del Universo y sus leyes.

Seguramente a sus responsables les espera el Nobel. Al mayor científico del siglo XX, que teorizó sobre ellas (sin evidencias directas ni indirectas ni un aparato tan potente como el LIGO) como consecuencia inevitable de la teoría de la relatividad general, el premio es una larga vida en la eternidad.

Crean una vacuna eficaz contra el virus del Ébola

El virus del Ébola es uno de los filovirus más temibles del mundo, ya que como sabemos provoca una enfermedad muy grave que provoca fiebres hemorrágicas y además es altamente contagioso, por lo que su potencial para causar epidemias es elevado.

Para hacernos una idea de lo peligroso que resulta basta recordar que el último brote de Ébola provocó la muerte de unas 11.000 personas, y sembró el miedo a nivel internacional por las posibles consecuencias que tendrá una infección a nivel global, ya que no hay una vacuna que permita hacerle frente de forma eficaz.

Por suerte el duro trabajo de científicos y expertos ha dado su fruto, ya que finalmente ha sido posible crear una vacuna que en los primeros ensayos y pruebas ha demostrado tener un 100% de eficacia, el doble comparada con la que se había probado en 2015. Esto es muy importante, ya que el uso de vacunas como elemento de prevención podría evitar que se produzcan brotes tan graves como el que se inició en Guinea a finales de 2013 y que mantuvo en alerta a la Organización Mundial de la Salud hasta el primer trimestre de 2016.

La vacuna todavía no ha recibido la aprobación necesaria para que pueda empezar a utilizarse de forma definitiva, pero se espera que se cumplan todos los requisitos para ello en algún momento de 2018.

Físicos del CERN logran observar y medir la antimateria

El grupo de investigación ALPHA del CERN, ha logrado medir la antimateria por primera vez en la historia. Un experimento pionero publicado en Nature que ha conseguido observar el espectro de luz de la antimateria, uno de los materiales más misteriosos del universo.

Los investigadores del CERN, el mayor laboratorio de investigación en física de partículas del mundo, han utilizado un láser para excitar las antipartículas (positrones y antiprotones) y comenzar a medir la estructura atómica de la antimateria, antihidrógeno en el experimento. El hidrógeno tiene un solo protón y un único electrón, por lo que es el átomo más simple y abundante para utilizar, aunque conseguir su contrapartida de antihidrógeno es sumamente difícil.

La antimateria suena como algo salido de la ciencia ficción. “La primera vez que oí hablar de la antimateria estaba viendo Star Trek , cuando era un niño”, explica Jeffrey Hangst, físico de la Universidad de Aarhus en Dinamarca y fundador del grupo de investigación ALPHA del CERN, que se dedica al estudio de la antimateria. Hangst explica que “lo que se escucha en la ciencia ficción sobre que la antimateria se aniquila con la materia normal es 100% verdad“, porque cada vez que la antimateria entra en contacto con la materia normal ambas desaparecen en un destello de luz y de ahí la dificultad de su estudio.

El experimento perseguía conocer si la materia y la antimateria verdaderamente obedecen a las mismas leyes de la física. “La medición del espectro del antihidrógeno con alta precisión ofrece una herramienta extraordinaria para probar si la materia se comporta de forma diferente de la antimateria”, explican los científicos.

Los resultados de la primera medición de la antimateria (antihidrógeno) no han mostrado diferencias con el hidrógeno (materia). Es solo un primer paso. El grupo de investigación ALPHA del CERN lleva trabajando en la antimateria desde hace 20 años.

Nuevos métodos de lucha contra el cáncer

El cáncer se mantiene como uno de los peores males que puede sufrir un ser humano, y no sólo porque los tratamientos actuales no siempre resultan efectivos, sino porque además los mismos son en ocasiones muy invasivos y porque su éxito depende de una detección temprana, cosa complicada dado que el cáncer es, por desgracia, un asesino silencioso.

Este año han sido varios los nuevos métodos presentados contra el cáncer. Un grupo de científicos canadienses ha desarrollado una nanopartícula capaz de cambiar de forma que permite marcar las células tumorales, haciendo posible que la quimioterapia se realice directamente sobre dichas células, sin afectar a las restantes células sanas presentes en el organismo. Esta especie de quimioterapia dirigida plantea importantes ventajas, ya que permitiría acabar con los terribles efectos secundarios que tiene el tratamiento en su estado actual, aunque todavía se encuentra en una fase temprana y tiene camino por recorrer antes de que empiece a ser aplicada en entornos reales.

Otro método ha sido propuesto por un grupo de científicos del UT de San Antonio y está especialmente indicado contra formaciones tumorales consideradas de difícil acceso, es decir, aquellas que se encuentran localizadas en lugares donde la cirugía es imposible o poco viable por implicar un gran riesgo para la vida del paciente.

La idea base detrás de este tratamiento es sencilla, se inyecta un compuesto de nitrobenzaldehído en el tumor y se espera que éste se difunda por el mismo. Posteriormente se aplica una luz ultravioleta sobre la masa tumoral, lo que hace que las células que lo forman adquieran un alto grado de acidez y acaben destruyéndose. De momento ha sido probado en ratones con una tasa de éxito fantástica, ya que el 95% de las células cancerígenas desaparecían tras la aplicación de este tratamiento, aunque se encuentra todavía en una fase muy temprana y su salto a humanos podría no ser igual de efectiva.

Por último, señalar los nuevos avances hacia la vacuna universal contra el cáncer, o la posibilidad de desarrollar una vacuna que nos haga inmunes a la enferemdad, es decir, que consiga que nuestro cuerpo reaccione y actúe desde el primer momento evitando que el cáncer llegue a desarrollarse e impida por tanto que pueda alcanzar su fase más peligrosa, la metástasis, en la que las células cancerígenas se extienden a otros tejidos y órganos y que acaba derivando en una muerte segura en poco tiempo.

Cuatro nuevos elementos para la tabla periódica

El pasado año se descubrieron cuatro nuevos elementos que ya tienen nombre definitivo, y que acaban de ser incluidos de manera oficial en la tabla periódica, con todo lo que ello supone para expertos, profesionales y estudiantes. Anteriormente conocidos por las numeraciones 113, 115, 117 y 118 desde hoy empezarán a ser identificados bajo los siguientes nombres:

- Elemento 113: Nihonio, por su descubrimiento en Japón. Su símbolo será Nh.

- Elemento 115: Moscovio, por su descubrimiento en Moscú. Su símbolo será Mc.

- Elemento 117: Téneso, por su descubrimiento en Tennessee. Su símbolo será TS.

- Elemento 118: Oganesón, en homenaje al científico Yuri Oganesián. Su símbolo será Og.

Por otro lado también es importante destacar que la introducción de esos cuatro elementos no marca un punto de descanso para los expertos, que ya están trabajando para dar forma a los primeros elementos que serán integrados en la octava fila de la tabla periódica.

Hawking: antes de 1.000 años debemos estar en otra Tierra

“No creo que podamos sobrevivir más de 1.000 años sin escapar de nuestro frágil planeta”, aseguró Stephen Hawking ante un millar de personas en el Festival Starmus que se celebra en Tenerife y La Palma, y que reunió a eminentes científicos (incluidos 11 premios Nobel) en una edición donde se rinde homenaje al físico teórico vivo más relevante del planeta.

Y de planetas habitables giró la charla de Hawking que insiste en la misma idea que lleva proclamando desde hace tres décadas: “la humanidad debe seguir viajando al espacio porque nuestro futuro no está en la Tierra”. Hawking es uno de los científicos detrás del proyecto Starshot, un programa que pretende enviar una flota de naves de exploración de inidicios de vida a Alfa Centauri, el sistema estelar más cercano al Sol (4,37 años luz).

El astrofísico celebró los avances en cosmología y los ambiciosos proyectos puestos en marcha en los últimos años, especialmente los destinados a conocer “de dónde venimos” nosotros y todo el Cosmos. “Nuestra imagen del Universo ha cambiado muchísimo en los últimos 50 años y me alegra mucho haber hecho una pequeña contribución”, explica.

“Los humanos no somos más que colecciones de partículas fundamentales de la naturaleza, y el hecho de que hayamos sido capaces de comprender gran parte de las leyes del Universo es un gran triunfo“, dijo Hawking, saludando la demostración de algunas de sus teorías sobre la formación del Universo o los agujeros negros, gracias a las misiones espaciales y la mejora en las mediciones.

La ciencia exonera al paciente cero del VIH

Durante décadas el paciente cero del VIH ha sido considerado como el responsable de la expansión de una de las enfermedades más letales del mundo, al menos en sus inicios, ya que hoy gracias a los tratamientos con retrovirales se encuentra “bajo control”.

Sí, hoy es posible llevar una vida bastante normal y plena incluso aún estando afectado por el virus del sida, aunque es necesario recordar que hasta el surgimiento de dichos tratamientos esta enfermedad era sinónimo de muerte casi segura, y además bastante terrible, ya que debilita a los enfermos hasta dejarlos convertidos casi en una sombra de lo que fueron. Uno de los ejemplos más claros en este sentido lo tenemos en Freddie Mercury.

El caso es que hasta hoy se venía señalando al paciente cero como principal culpable del inicio del sida, un asistente de vuelo que habría mantenido relaciones sexuales con personas diferentes en todos los lugares por los que viajaba debido a su profesión, pero la ciencia finalmente lo ha exonerado por completo.

Las últimas investigaciones realizadas con secuencias de ARN han demostrado que las muestras del hasta ahora conocido como paciente cero no son las más antiguas que existen, sino que se sitúan en un punto posterior al de otras que nos llevan directamente a principios de los años setenta.

Esto quiere decir que el virus del sida ya estaba en Estados Unidos antes de la llegada del paciente cero, y que el mismo ha ido experimentando ciertas mutaciones desde entonces que han permitido diferenciar por etapas (o años) las distintas muestras que existen.

¿Pudo equivocarse Einstein en la constante de la velocidad de la luz?

Un grupo de científicos detrás de la teoría de una velocidad de la luz variable y no constante como establecen leyes y teorías como la relatividad general de Einstein, dicen que cuentan con un método para probarlo.

Según la física de Einstein y la de otras teorías aceptadas para explicar el origen y expansión del universo, la velocidad de la luz es una constante en todos los marcos de referencia. Sin embargo, hace años que algunos físicos y cosmólogos la están cuestionando y apuestan por investigar en un nuevo marco teórico que explique el Universo y algunos fenómenos cosmológicos desconcertantes.

La constante de la velocidad de la luz puede sonar como el tipo de cosas intrascendentes que debaten los científicos, pero atreverse a contradecir el modelo de la física de Einstein tiene repercusiones en nuestra manera de entender el universo, tanto en la actualidad como en el pasado. Los que ponen en duda ese modelo, explican que la velocidad de la luz constante no es capaz de explicar por qué el universo hoy en día es tan inmenso, tan homogénea en su densidad y en gran medida uniforme en todas partes.

Con el fin de resolver la cuestión los científicos teorizan que la velocidad de la luz no es realmente constante. Al comienzo de la gran explosión, habría viajado más rápido. A medida que el universo se estableció y la expansión se ralentizó. también lo hizo la velocidad de la luz. Aunque todo esto es teoría, los científicos dicen haber encontrado una manera de probarlo. Los científicos han estudiado el mapa de microondas cósmico, que es la historia de la luz, del universo, y han utilizado un modelo para predecir un número específico de “índice espectral”.

Si dentro de unos años su predicción coincide con lo que realmente se observó en el índice, confirmarían su teoría como válida y Einstein estaría equivocado en su teoría con todo lo que ello implica porque toda la física teórica está basada en ella. El índice y el modelo será publicado Physical Review D y promete debate…

Desvelan el misterio de nuestra abuela Lucy

Lucy, una Australopitechus afarensis que vivió hace 3,18 millones de años y que estuvo considerada en su momento como nuestra “abuela más remota”, murió al caer de un árbol como la causa más probable, según concluye una investigación de la Universidad de Texas publicada en Nature.

Lucy no es cualquiera. Descubierta fosilizada en Etiopía en 1974, sorprendió ante lo completo que estaba su esqueleto, casi la mitad del total. El asombro de los paleontólogos llegó después cuando comprobaron que sus características físicas eran inusuales. Por un lado tenía piernas y brazos como un chimpancé, pero la pelvis ancha indicaba que caminaba erguida. Esta combinación de rasgos sugirió que su especie, Australopithecus afarensis, pudo ser un vínculo entre los humanos modernos y nuestros antepasados arborícolas y por ello, se consideró a Lucy como uno de los descubrimientos más importantes para entender la evolución humana.

Desde el hallazgo de este ancestro humano bípedo, se ha discutido si Lucy pasaba tiempo en los árboles y se ha intentado conocer la causa de su muerte. Y no ha sido fácil porque han tardado más de 40 años. Ahora parece desvelado el misterio: Lucy se cayó de un árbol desde una altura entre 10 a 14 metros, golpeando el suelo a más de 56 km por hora y no pudo superar las heridas. Hace más de tres millones de años Lucy hizo lo que cualquier humano hubiera hecho. Aterrizó con los pies pero cayó hacia adelante y entonces intentó frenar la caída estirando el brazo.

Es la conclusión de una investigación que utilizó una instalación Tomográfica de rayos X de Alta Resolución para crear un archivo digital de 35.000 imágenes. Los investigadores observaron una fractura inusual en el húmero que no se ve en los fósiles y que es una marca única cuando una mano toca el suelo en una caída, y el impacto se transmite a través del brazo.

Los investigadores creen que su doble capacidad como arborícola y terrestre, podrían haber debilitado su capacidad de trepar y moverse por los árboles porque es extremadamente extraño que -por ejemplo- un chimpancé se caiga y muera por esta causa. Lucy era distinta, nuestro ancestro más famoso fue un vínculo entre los humanos modernos y nuestros antepasados arborícolas. Las múltiples fracturas acabaron rápidamente con su vida cuando tenía entre 12 y 20 años de edad y hace más de tres millones de años.

¿Es posible la inmortalidad?

Un grupo de investigadores asegura que la inmortalidad es un sueño, y no sólo eso, sino que han llegado a la conclusión de que lo máximo que podemos llegar a vivir en este planeta son 115 años. Esa esperanza de vida máxima se aplica a supuestos en los que la persona se cuida y hace todo lo necesario para mantenerse en buena forma, hábitos que sólo lleva a cabo de forma regular una parte muy pequeña de la población global.

Desde un punto de vista sensato y razonable debemos reconocer que con los medios, condiciones y estilos de vida actuales vivir 100 años ya es todo un logro, y hoy por hoy la idea de la inmortalidad es efectivamente un sueño, pero podría no serlo en un futuro. No podemos concretar una fecha, pero está claro que los avances que estamos haciendo en ingeniería genética irán dando poco a poco sus frutos, una realidad que unida a otros avances de tipo quirúrgico e incluso a la impresión en 3D de tejidos y órganos podría ayudarnos a conseguir tan ambiciosa meta.

A este respecto, este año se han presentado avances que en un futuro podría convertir el sueño de la inmortalidad en una realidad. Un grupo de científicos está dispuesto a sacar adelante un proyecto que ha generado una gran controversia: crear la humanidad perfecta y con ello extender la vida.

Dicho proyecto se conoce como HGP-Write y se centra en la creación de ADN desde cero, es decir, en la elaboración de genes sintéticos que podrían ser posteriormente implantados en seres humanos sin mayor problema y que tendrían un efecto terapéutico. Muy interesante, sin duda, pero sus posibilidades podrían ir más allá, ya que según los expertos no descartan que esta nueva técnica pueda servir incluso para crear nuevos órganos humanos totalmente funcionales.

Otra de las investigaciones interesantes en este sentido llegan de la primera terapia contra el envejecimiento. Según Elizabeth Parrish, CEO de Bioviva USA Inc, han sido los primeros en aplicar con éxito en humanos una terapia genética experimental contra el envejecimiento dividida en dos grandes versiones, una dirigida a frenar la pérdida de masa muscular y otra para luchar contra la reducción de células madre, ambas consecuencias directas de la edad.

La clave de todo está en los telómeros, segmentos cortos de ADN que se encuentran al final de cada cromosoma y que actúan amortiguando los efectos del paso del tiempo de forma permanente, aunque con los años se acaban desgastando de forma inevitable, lo que deriva en fallos y en un envejecimiento. Con esto en mente es más sencillo entender cómo funciona la terapia de Bioviva, revirtiendo el acortamiento de los telómeros, un proceso de momento afirman haber sido capaces de conseguir en un nivel máximo de 20 años.

Fuente:

http://www.muycomputer.com/2016/12/29/ciencia-en-2016/

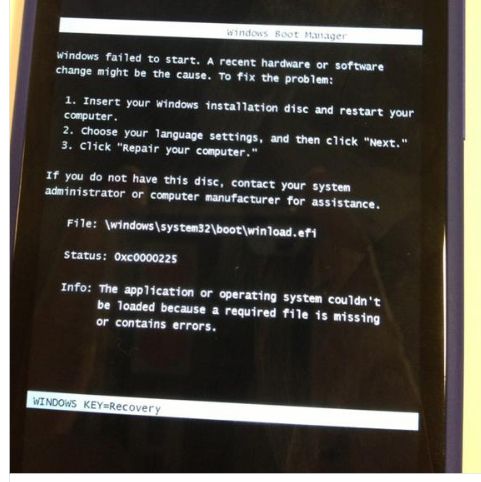

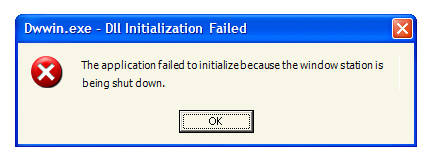

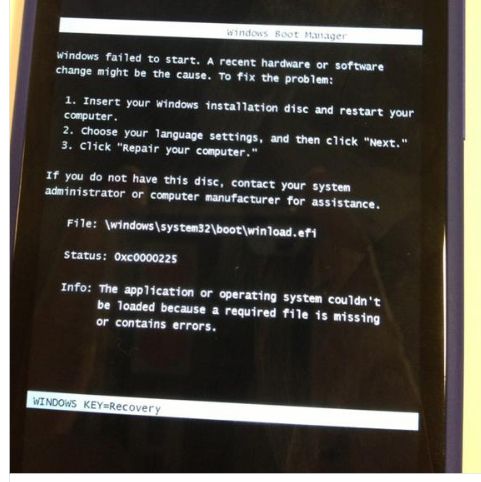

La pantalla verde de la muerte en Windows es muy real

La pantalla verde de la muerte (Green Screen of Death – GSOD) está reemplazando a la conocida como “pantalla azul de la muerte” en la última versión de prueba de Windows 10.

Como sabes, las pantallas azules de la muerte (Blue Screen Of Death – BSOD) nos llevan acompañando desde hace muchos años en los sistemas Windows. Se producen por un error crítico del sistema operativo y obligan a reiniciarlo. La misma pantalla ofrece información del fallo, pero en un modo texto y de manera tan críptica que muy pocos pueden gestionarla para intentar evitarlo antes de que se produzca de nuevo.

Aunque a partir de Windows 7 se redujo el número de estos fallos frente a Windows XP, por la mejora en la estabilidad del sistema y por la propia gestión de las BSOD que realiza el sistema, Microsoft ha buscado mejorarla en Windows 10, simplificando el proceso de diagnóstico y la solución de los problemas que causan los fallos del sistema.

Para ello, Microsoft añadió códigos QR que permiten al usuario acceder directamente a los recursos necesarios para solucionar el problema específico que causó el bloqueo de su ordenador personal.

Ahora, Microsoft se prepara para un cambio más radical al menos de imagen, con una pantalla verde de la muerte que ha aparecido en las versiones de prueba Insider.

No se conoce si GSOD reemplazará por completo a BSOD en las próximas versiones estables o si ambas serán utilizadas para diferenciar las versiones de prueba. Lo que sí puedes asegurar es que sea verde o azul, estos pantallazos seguirán provocando un escalofrío al usuario que sufra el error crítico del sistema. Y nos tememos que el gran público seguirá sin saber los motivos…

Fuente:

http://www.muycomputer.com/2016/12/29/pantalla-verde-de-la-muerte/

Como sabes, las pantallas azules de la muerte (Blue Screen Of Death – BSOD) nos llevan acompañando desde hace muchos años en los sistemas Windows. Se producen por un error crítico del sistema operativo y obligan a reiniciarlo. La misma pantalla ofrece información del fallo, pero en un modo texto y de manera tan críptica que muy pocos pueden gestionarla para intentar evitarlo antes de que se produzca de nuevo.

Aunque a partir de Windows 7 se redujo el número de estos fallos frente a Windows XP, por la mejora en la estabilidad del sistema y por la propia gestión de las BSOD que realiza el sistema, Microsoft ha buscado mejorarla en Windows 10, simplificando el proceso de diagnóstico y la solución de los problemas que causan los fallos del sistema.

Para ello, Microsoft añadió códigos QR que permiten al usuario acceder directamente a los recursos necesarios para solucionar el problema específico que causó el bloqueo de su ordenador personal.

Ahora, Microsoft se prepara para un cambio más radical al menos de imagen, con una pantalla verde de la muerte que ha aparecido en las versiones de prueba Insider.

No se conoce si GSOD reemplazará por completo a BSOD en las próximas versiones estables o si ambas serán utilizadas para diferenciar las versiones de prueba. Lo que sí puedes asegurar es que sea verde o azul, estos pantallazos seguirán provocando un escalofrío al usuario que sufra el error crítico del sistema. Y nos tememos que el gran público seguirá sin saber los motivos…

Fuente:

http://www.muycomputer.com/2016/12/29/pantalla-verde-de-la-muerte/

Capcom parchea la demo de Resident Evil 7, compatible con más procesadores

La compañía nipona ha lanzado reciente un parche muy importante para Resident Evil 7 que introduce mejoras que van más allá del aumento de rendimiento y la resolución de problemas.

Como apuntó alguno de nuestros lectores la primera versión de la demo para PC no funcionaba en CPUs Phenom II de AMD y los Core 2 de primera generación (núcleo Conroe). El problema estaba en que el juego no era compatible con aquellos procesadores que carecen de las instrucciones SSE 4.1, cosa que por suerte queda corregida con este nuevo parche.

Si instalas el parche podrás jugar a la demo incluso aunque tu CPU carezca de SSE 4.1, y suponemos que lo mismo ocurrirá con el juego en su versión final, que debería funcionar a la perfección en dichos procesadores.

A nivel de rendimiento la demo reduce el impacto del HBAO+, que consumía una exageración de recursos y reducía considerablemente la tasa de fotogramas por segundo, y se han corregido algunos errores menores.

Sigo pensando que Capcom ha hecho un buen trabajo con Resident Evil 7, al menos valorando lo que he podido ver en la demo. La ambientación es buena y está muy cuidada, la calidad gráfica raya a un buen nivel y han conseguido dar forma a un auténtico survival horror.

Fuente:

http://www.muycomputer.com/2016/12/29/demo-resident-evil-7-compatible-mas-procesadores/

Como apuntó alguno de nuestros lectores la primera versión de la demo para PC no funcionaba en CPUs Phenom II de AMD y los Core 2 de primera generación (núcleo Conroe). El problema estaba en que el juego no era compatible con aquellos procesadores que carecen de las instrucciones SSE 4.1, cosa que por suerte queda corregida con este nuevo parche.

Si instalas el parche podrás jugar a la demo incluso aunque tu CPU carezca de SSE 4.1, y suponemos que lo mismo ocurrirá con el juego en su versión final, que debería funcionar a la perfección en dichos procesadores.

A nivel de rendimiento la demo reduce el impacto del HBAO+, que consumía una exageración de recursos y reducía considerablemente la tasa de fotogramas por segundo, y se han corregido algunos errores menores.

Sigo pensando que Capcom ha hecho un buen trabajo con Resident Evil 7, al menos valorando lo que he podido ver en la demo. La ambientación es buena y está muy cuidada, la calidad gráfica raya a un buen nivel y han conseguido dar forma a un auténtico survival horror.

Fuente:

http://www.muycomputer.com/2016/12/29/demo-resident-evil-7-compatible-mas-procesadores/

Un simple test de aliento puede detectar el cáncer

Detectar el cáncer cuando se encuentra en un estado temprano es vital para poder hacer frente a la enfermedad con garantías de éxito, aunque por desgracia es algo que todavía resulta complicado y que no siempre se consigue.

Por suerte numerosos expertos y científicos siguen trabajando duro para descubrir nuevas formas de análisis que permitan una detección temprana, y que además sean sencillas, eficientes y rápidas.

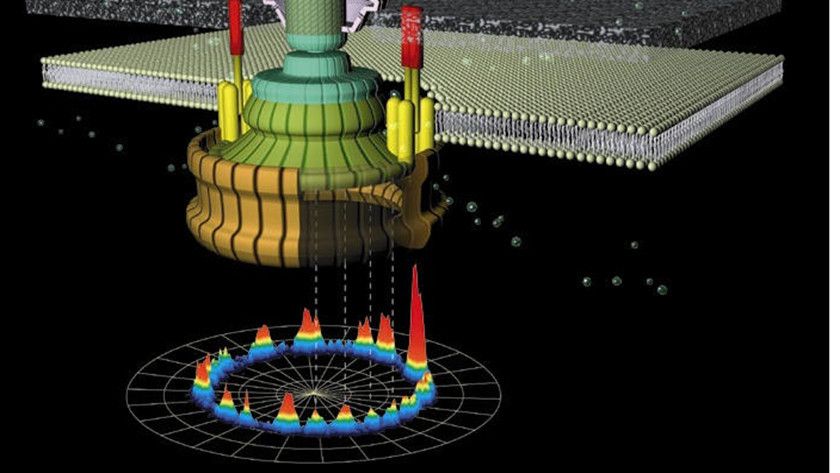

En este sentido el último gran hito lo han conseguido un grupo de investigadores del Instituto de Tecnología de Israel, que han desarrollado un sistema que es capaz de identificar hasta 17 enfermedades diferentes analizando el aliento de una persona.

La clave de este importante avance se encuentra en el uso de sensores basados en nanopartículas de oro y una red de nanotubos de carbono, que son capaces de reconocer e identificar diferentes compuestos presentes en el aliento de un ser humano.

Esos compuestos son posteriormente analizados por un sistema de inteligencia artificial, que se encarga además de poner en relación todos los datos obtenidos con otra información importante, como por ejemplo la edad del paciente, su sexo y otros factores que puedan tener relevancia de cara a ofrecer un diagnóstico.

Entre las enfermedades que ha sido capaz de identificar con éxito se encuentran por ejemplo el Parkinson, la diabetes y ocho tipos diferentes de cáncer.

Su tasa de acierto todavía no es lo bastante buena como para ser utilizada en entornos reales, pero muestra un potencial claro y con las mejoras adecuadas podría acabar convirtiéndose en una solución viable y muy útil.

Fuente:

http://www.muycomputer.com/2016/12/29/test-aliento-detectar-cancer/

Diez momentos destacados de alta Tecnología en 2016

Vamos cerrando el año con los últimos artículos recopilatorios y hoy toca revisar lo que ha dado de sí el mundo de la alta Tecnología en 2016. Como el dedicado a Ciencia en 2016,

solo es una pequeña muestra de todo lo que hemos ido publicando a lo

largo del año en campos como la supercomputación, la robótica o la

Inteligencia Artificial.

Crear un computador cuántico que supere todo lo conocido en capacidad de proceso, será uno de los grandes saltos tecnológicos y en ello están trabajando -en secreto y en abierto- múltiples equipos disciplinares. IBM tiene uno de los equipos más avanzados y ha anunciado una plataforma en la nube de computación cuántica, denominada IBM Quantum Experience, que permitirá a los usuarios hacer experimentos y construir algoritmos sobre este procesador.

También podrán trabajar con bits cuánticos (qubits) y estudiar tutoriales y realizar simulaciones sobre las posibilidades de la computación cuántica. Se podrá acceder a esta plataforma a través de IBM Cloud desde cualquier ordenador o dispositivo móvil. El procesador cuántico está compuesto por cinco qubits superconductores alojados en el centro de investigación IBM T.J. Watson Research Center de Nueva York. Los cinco procesadores qubit son el ultimo avance de IBM en cuanto a arquitectura cuántica capaces de incrementar su escala para mayores sistemas cuánticos.

Ya conoces como frente a los bits de la computación tradicional capaces de adoptar un valor de 1 o 0, la información en computación cuántica se almacena en qubits (bits cuánticos) que pueden adoptar simultáneamente ambos valores (superposición). Un ordenador cuántico universal podrá programarse para realizar cualquier tarea de computación y será exponencialmente más rápido que los sistemas clásicos para un gran número de aplicaciones científicas y de negocio.

IBM prevé que durante la próxima década ya habrá disponibles procesadores de tamaño medio de entre 50-100 qubits. Se trata de una tecnología con un potencial enorme. Un ordenador cuántico de tan solo 50 qubits hará palidecer a cualquier superordenador del top-500 mundial.

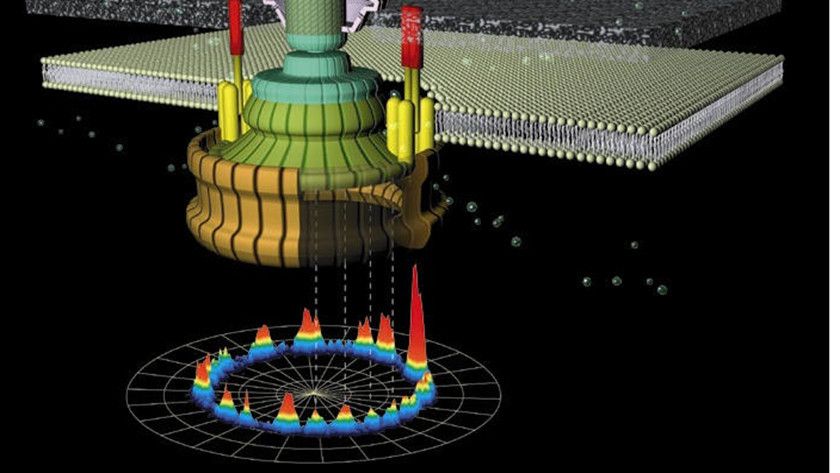

La investigación con máquinas moleculares y por extensión la nanotecnología, ha recibido un reconocimiento a través del anuncio del premio Nobel de Química 2016, otorgado al francés Jean Pierre Sauvage, el británico J. Frasser Stoddart y el holandés Bernard Feringe.

Tres científicos pioneros en este campo entre la química y la mecánica, que se llevan el galardón por el diseño y síntesis de máquinas moleculares que pueden ser utilizadas en “el desarrollo de nuevos materiales, sensores y sistemas de almacenamiento de energía”, explicó el jurado al anunciar el galardón.

Los premiados “han miniaturizado máquinas y llevado la química hacia una nueva dimensión. Han conducido los sistemas moleculares hacia estados donde, al llenarse de energía, pueden controlarse sus movimientos”, señalan desde la Academia de Ciencias Sueca.

Las máquinas moleculares darán lugar a nuevas tecnologías de computadoras y con ello, nuestro campo informático será uno de los principales campos de aplicación. Destacar que, el británico Stoddart, ya ha desarrollado un chip de computadora molecular con 20 kB de memoria. Unos chips que pueden revolucionar la tecnología de computadoras en el futuro como en su día hicieron los transistores de silicio, al posibilitar la creación de ordenadores moleculares que almacenarían y gestionarían la información a nivel molecular.

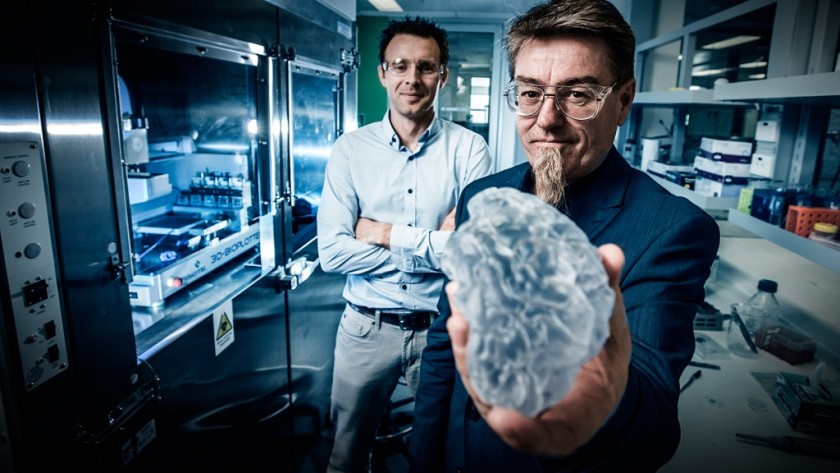

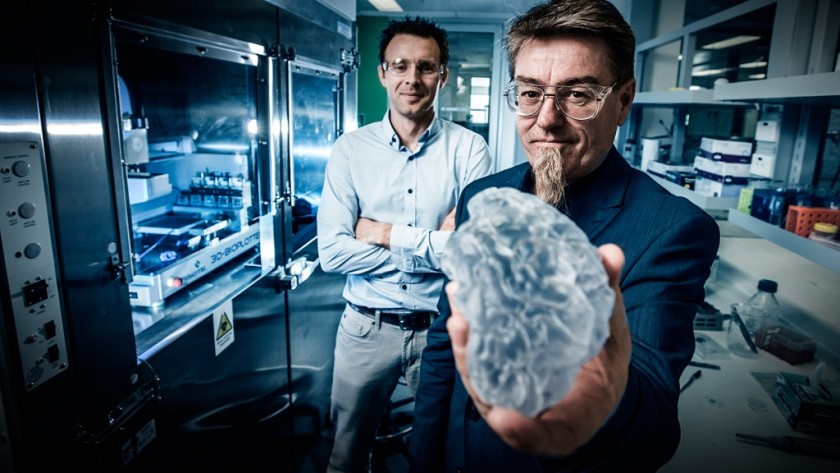

La impresión 3D de tejidos vivos, también conocida como bioimpresión 3D, es una tecnología que ha ido demostrando poco a poco que puede convertirse en una herramienta de gran utilidad para los médicos. Con ella no sólo es posible crear prótesis y tejidos, sino que además ofrece la posibilidad de crear desde huesos hasta órganos con las propias células del paciente, un detalle importante ya que acaba con uno de principales problemas de los trasplantes, el rechazo.

Su potencial está fuera de toda duda, aunque su implementación e integración en hospitales no se había llevado a cabo en hospitales, algo que pronto cambiará gracias al trabajo de Queensland University of Technology de Brisbane, situada en Australia.

Los expertos de dicha universidad tienen pensado crear una instalación dedicada a la bioimpresión 3D que estará instalada en un hospital de primer nivel y no, no hablamos de algo pequeño, sino de una apuesta muy ambiciosa, ya que dicha instalación ocupará dos plantas.

Un movimiento muy interesante que sin duda abre las puertas al futuro, a una medicina casi “de ciencia ficción” en la que puede que pronto lleguemos a ser capaces de imprimir todos los elementos que necesitemos para salvar vidas. ¿También órganos complejos?

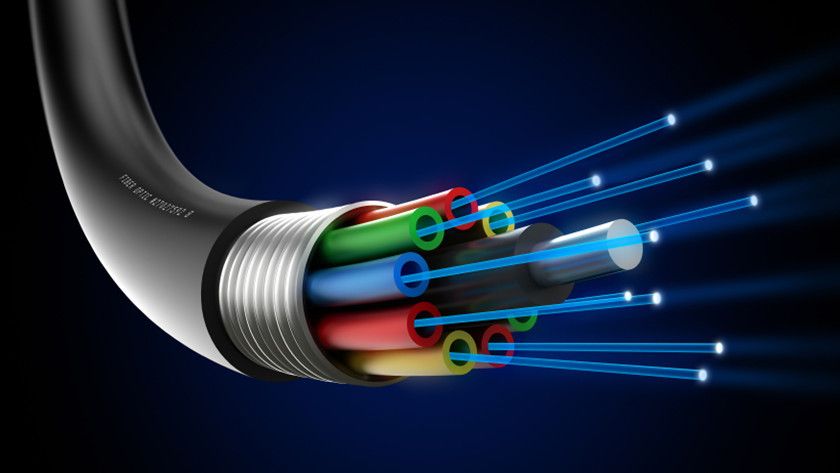

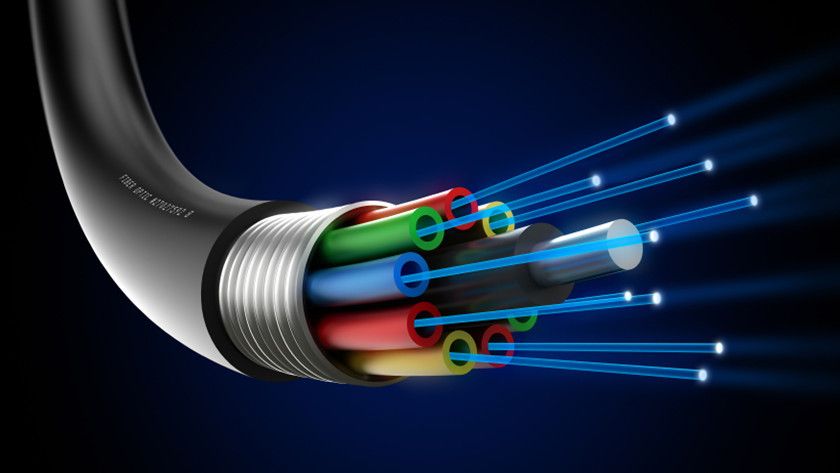

En el mes de junio se celebró el 50 aniversario del comunicado de Sir Charles Kuen Kao a la Asociación Británica para el Avance de la Ciencia, que abrió el desarrollo de la fibra óptica en telecomunicaciones. Kao, considerado el “padre de la comunicación por fibra óptica” y premiado por ello con el Nobel de Física en 2009, propuso el uso de fibras de vidrio y de luz en lugar de electricidad y conductores metálicos, para la transmisión de mensajes telefónicos.

Fue el comienzo de una revolución que llega hasta nuestros días si bien el uso de la luz solar para transmitir información ya era utilizado de forma rudimentario por los antiguos griegos. En el siglo 18, un investigador francés diseñó un sistema de telegrafía óptica que permitía enviar un mensaje a 200 kilómetros en 16 minutos utilizando un código, torres y espejos y en 1840, fue demostrado el principio que posibilita la fibra óptica (confinamiento de la luz por refracción) y en 1870 se descubrió que la luz podía viajar dentro del agua, curvándose por reflexión interna.

Fueron los inicios aunque la fibra óptica para telecomunicaciones no interesó verdaderamente a los investigadores hasta 1950, cuando se empezó a utilizar filamentos delgados como el cabello que transportaban luz a distancias cortas. Los estudios de Kao permitieron avanzar en el uso de nuevos materiales y técnicas de fabricación y en la década de los 70 ya se consiguieron pérdidas de tan solo 0,5 dB/km, mientras que en abril de 1977, General Telephone and Electronics envió la primera transmisión telefónica a través de fibra óptica, en 6 Mbit/s.

El primer enlace transoceánico con fibra óptica fue el TAT-8 que comenzó a operar en 1988 y a partir de ahí el uso de la fibra óptica para telecomunicaciones ha sido fundamental para llegar a la era de la conectividad total en la que nos encontramos. Mucho le debemos a la propuesta del “padre de la comunicación por fibra óptica”,

El almacenamiento ADN es un proyecto de ciencia ficción en el que están trabajando varios equipos de investigación. Las tecnológicas tienen un gran interés en lo que podría ser una auténtica revolución y se conoció que Microsoft compró diez millones de hebras de ADN a Twist Bioscience, una startup especializada que está colaborando con los de Redmond y la Universidad de Washington.

La investigación en almacenamiento biológico trata el ADN como cualquier otro dispositivo de almacenamiento digital. En lugar de datos binarios que se codifican como regiones magnéticas en un plato de unidad de disco duro, se sintetizan hebras de ADN que almacenan 96 bits donde cada una de las bases (TGAC) representan un valor binario (T y G = 1, A y C = 0).

Para leer la información almacenada en el ADN, sólo se tiene que secuenciar -como si fuera un genoma humano- y convertir cada una de las bases TGAC de nuevo en binario. Para ayudar con la secuenciación, cada hebra de ADN tiene un bloque de direcciones de 19-bit al principio (los bits de color rojo en la imagen de abajo) por lo que el ADN puede ser secuenciado fuera de orden y luego clasificarse en datos utilizables utilizando las direcciones.

Las ventajas del almacenamiento ADN son notables. Su increíble densidad permitiría almacenar 1.000 millones de Tbytes en un gramo. Como ejemplo, para almacenar la información de una simple gota de ADN necesitaríamos 233 discos duros de 3 Tbytes con un peso total de 151 kilogramos.

Además de capacidad, sería una memoria con un consumo de energía cero, podría sobrevivir inalterable durante miles de años y la tecnología podría usarse mientras existiera vida en la Tierra, algo que no puede ofrecer ningún otro tipo de “material”. Por lo demás, es posible almacenar los datos en el ADN de las células vivas (aunque sólo por un corto tiempo). Imagina un espía como James Bond llevando en su piel datos para transferencias seguras.

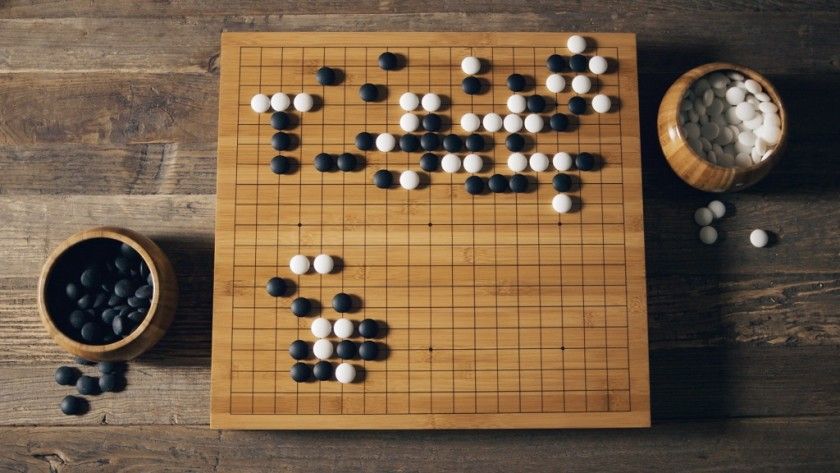

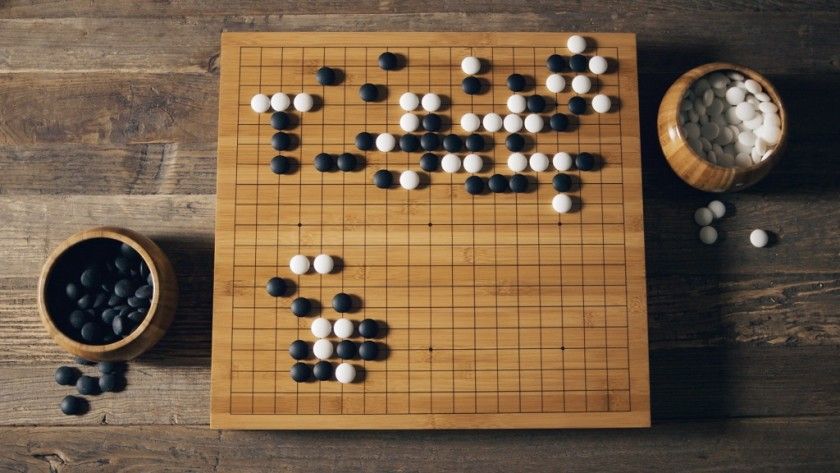

En una muestra de los avances en Inteligencia Artificial, AlphaGo, la máquina de Inteligencia Artificial de Google, venció al campeón humano de Go.

Recordarás las partidas de ajedrez entre Gary Kasparov y la supercomputadora Deep Blue de IBM. Una competición que en 1996 saltó a las portadas de los todos los medios mundiales cuando el campeonísimo ruso perdió la primera partida. Era la primera vez que una computadora ganaba al campeón del mundo en condiciones normales de torneo, con un tiempo de control igual que en las competiciones oficiales de ajedrez.

En el mes de marzo se celebró una competición similar pero con Go, el juego de tablero estratégico original de la antigua china hace 2.500 años, extendido unos siglos después a Japón y Corea. AlphaGo ya venció a un gran maestro de este juego (considerado una de las cuatro artes esenciales de la cultura china de la antigüedad) el pasado noviembre y ahora ha sido mejorado para enfrentarse al campeón del mundo, al que venció en un enfrentamiento a cinco partidas.

Go es un juego de estrategia muy compleja a pesar de la simpleza de sus reglas por lo que AlphaGo ha ido mejorando su algoritmo usando lo que llaman “redes de valor” para evaluar posiciones y “redes de táctica” para mover las fichas.

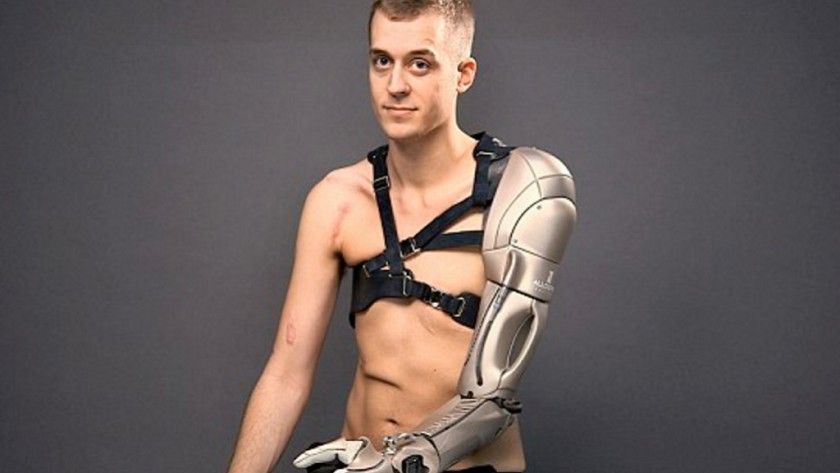

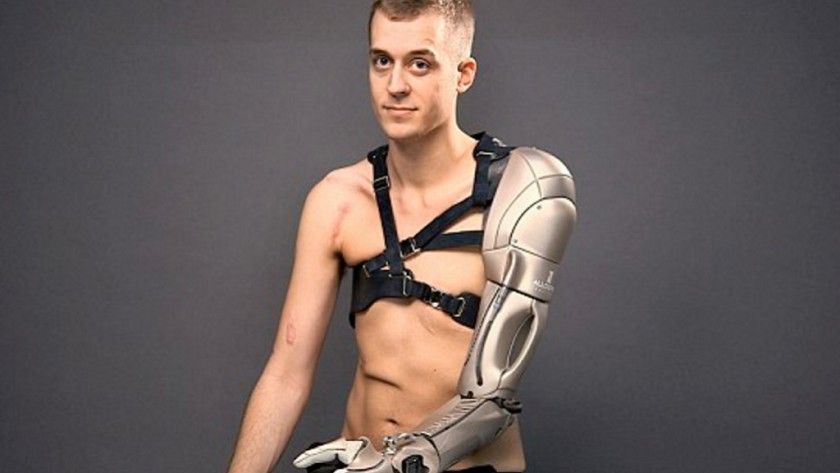

Las amputaciones de extremidades son uno de los mayores traumas que puede enfrentar un ser vivo, aunque gracias a los avances de la tecnología y la ciencia cada vez es posible encontrar opciones más avanzadas que pintan un futuro a medio plazo realmente esperanzador, y el brazo biónico de Konami (sí, la misma que hace videojuegos) es uno de los mejores ejemplos que podemos poner.

Hablamos de una prótesis que se encuentra en fase de prueba, aunque su portador, un joven de 26 años que perdió el brazo izquierdo y una pierna en un desafortunado incidente al caer a las vías del tren, es capaz de llevar una vida mucho más fácilgracias a él.

Este espectacular implante está conectado a los nervios y a la musculatura de su hombro y tiene un funcionamiento bastante completo en todos los sentidos, es decir, tanto de movilidad del brazo como de la mano, ya que le permite realizar acciones complejas e incluso coger objetos muy pequeños, incluidos algunos tan difíciles como las monedas.

Como habréis intuido cuenta con un sistema que convierte las señales nerviosas y los impulsos musculares captados en el hombro en movimiento, pero junto a éstas cuenta también con otras capacidades tan futuristas como útiles, entre las que destacan el cargador de smartphone integrado, una linterna y un puntero láser.

Científicos de la Universidad de Oxford han creado el material más caro del mundo, con un precio que ronda los 100.000 dólares por cada 600 microgramos (lo que pesa un cabello humano). No, no es una joya, ni un activo nuclear, ni una nueva droga, sino de un fullereno, la tercera forma molecular más estable del carbono, tras el grafito y el diamante, y que puede ser otra base de investigación que permita obtener nuevos superconductores no convencionales que revolucionen la electrónica.

Descubierto en 1985, el fullereno más conocido es el formado por 60 átomos de carbono. El mismo equipo que los descubrió halló recientemente un nuevo estado de la materia (metálico) bajo el efecto Jahn-Teller, que permitiría obtener superconductores no convencionales que dicen “revolucionarán la electrónica”.

Su campo de aplicación es muy amplio aunque las investigaciones están en etapas iniciales. Se cita como ejemplo su uso en relojes atómicos donde estos fullerenos reducirían su tamaño de un armario a un microchip. Ello permitiría instalarlos en un GPS o en un teléfono móvil, para conseguir una precisión de 1 milímetro frente a la actual entre 1 y 5 metros.

La Universidad de Oxford vendió recientemente a un laboratorio 200 microgramos de fullereno endoédrico por 32.000 dólares, batiendo todos los récords porque un gramo costaría 145 millones de dólares. Como curiosidad. Si el fullereno es el material más caro del mundo, la NASA estableció que la antimateria sería lo único capaz de rivalizar con él. Y le puso precio: 61.000 millones de dólares por gramo.

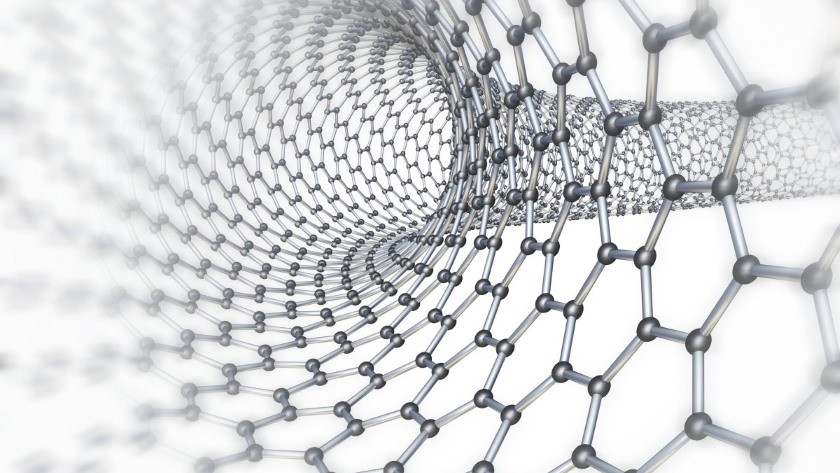

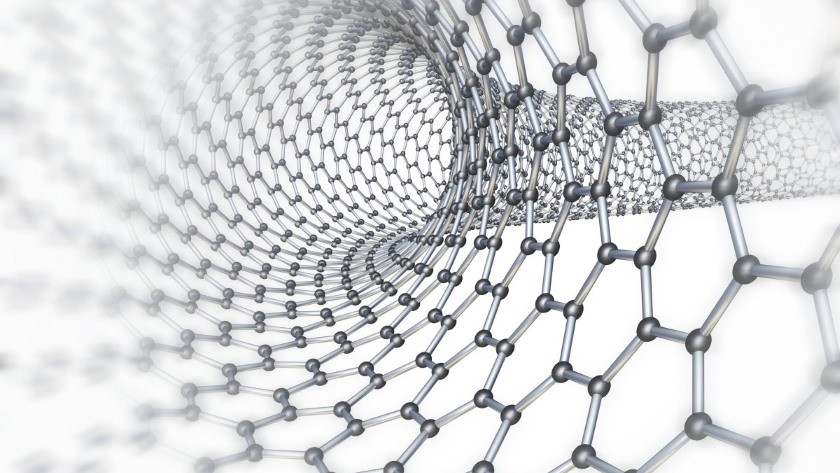

Hace años que venimos hablando del fin del silicio y de la necesidad de una evolución disruptiva en la fabricación de microprocesadores para mantener la vigencia de la Ley de Moore; hoy sabemos que un equipo de investigadores de IBM ha realizado un descubrimiento que podría ser clave; no se trata de construir chips, sino de cultivarlos.

Las estructuras basadas en nanotubos de carbono serán una pieza muy importante para el futuro de la tecnología; además de permitir el desarrollo de chips todavía más rápidos y eficientes, podrían ser la base de innovaciones como ordenadores o smartphone flexibles y ultrafinos, nano-máquinas que podrían entrar en nuestro cuerpo para curar enfermedades o ropa inteligente repleta de sensores y capacidad de proceso.

Los nanotubos no son un desarrollo nuevo pero, hasta el momento, los investigadores siempre se había topado con grandes dificultades para construir estructuras con ellos. Por definición, son increíblemente pequeños así que muchos de los procesos de fabricación que sírven para el silicio no son válidos a escala nanoscópica.

El anuncio, aunque esperanzador, no es nuevo. Ya hace algunos meses hablamos en MuyComputerPRO de cómo un equipo de IBM Research había realizado avances importantes con los nanotubos de carbono. Lo relevante es que se cambia la perspectiva, una vez entendido que un proceso mecánico de fabricación a esta escala es poco menos que imposible.

Evidentemente, todavía estamos lejos de ver los primeros chips fabricados con nanotubos; la industria del silicio es poderosa y se están consiguiendo retos increíbles como los 10 nm que consiguió Samsung hace muy poco pero, al menos, parece que se vislumbra una alternativa que podría romper todos los límites que damos por seguros a día de hoy.

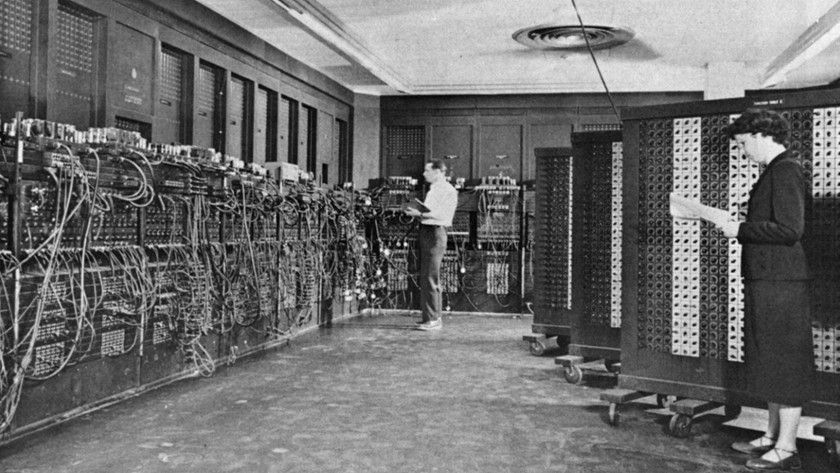

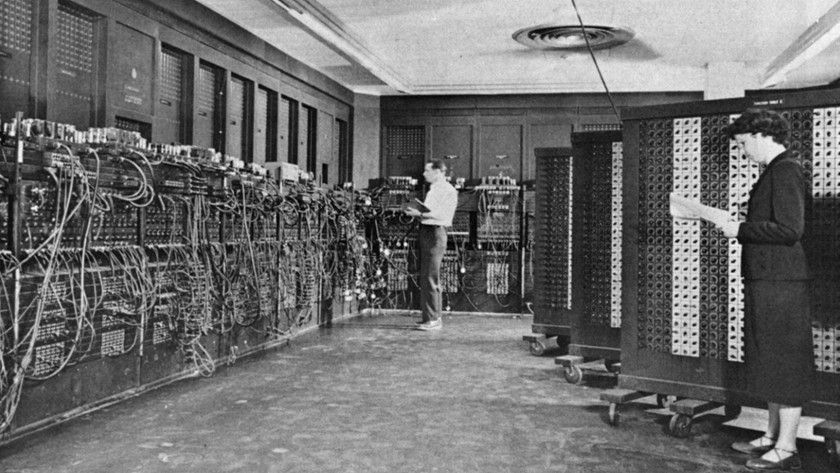

La historia de las computadoras es tan grande que llega hasta el año 2.700 a.C, cuando las civilizaciones sumerias y chinas utilizaban el ábaco para realizar sumas y restas. Mucho más tarde se inventó el algoritmo, el cálculo numérico, la regla de calculo, la máquina de calcular, la tarjeta perforada o la primera calculadora automática que se fabricó y empleó a escala industrial.

En 1936 llegó la revolución cuando el matemático Alan Turing -considerado con justicia el “padre de la ciencia de la computación”– formalizó los conceptos de algoritmo y de máquina de Turing, introdujo el concepto de la Hypercomputación, los primeros avances teóricos de Inteligencia Artificial y el diseño de los primeros computadores electrónicos programables digitales.

Además de ayudar al mundo a terminar con los nazis gracias a las máquinas de descifrado Enigma y los codificadores de teletipos FISH, las aportaciones de Turing fueron clave para el desarrollo de la computación moderna y la posterior llegada del IBM PC que abrió la era del ordenador personal.

Unas décadas antes, llegaron al mercado computadoras clásicas como las que te ofrecemos de la mano de imágenes creadas por el fotográfo James Ball (‘Docubyte’). Son verdaderas obras de arte aunque no están “todas las que son” y se podrían incluir otras míticas anteriores como Colossus, ENIAC o el IBM CPC.

Fuente:

http://www.muycomputer.com/2016/12/30/tecnologia-en-2016/

Así es el computador cuántico de IBM

Crear un computador cuántico que supere todo lo conocido en capacidad de proceso, será uno de los grandes saltos tecnológicos y en ello están trabajando -en secreto y en abierto- múltiples equipos disciplinares. IBM tiene uno de los equipos más avanzados y ha anunciado una plataforma en la nube de computación cuántica, denominada IBM Quantum Experience, que permitirá a los usuarios hacer experimentos y construir algoritmos sobre este procesador.