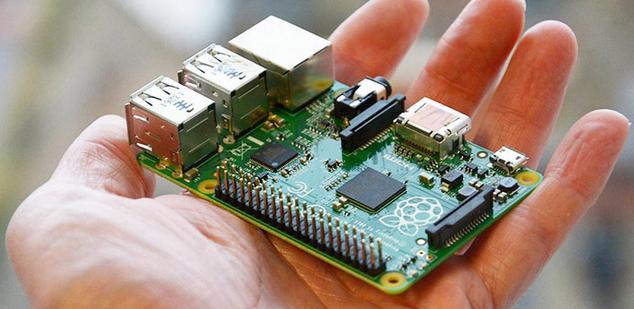

Los fundadores de Raspberry Pi han sido claros y tajantes: No habrá Raspberry Pi 4 por el momento. Sin embargo, esto no significa que no podemos pensar o buscar los componentes que la futura Raspberry Pi 4 debería de tener o que se debería de tener en cuenta para la próxima versión.

Medidas y tamaños

Las medidas de esta placa SBC son cada vez más importantes y si he visto durante los últimos meses que han sacado versiones reducidas de Raspberry Pi, la 4ª versión no debería de dejar de lado esta característica. El modelo Raspberry Pi 3 tiene estas medidas 85 x 56 x 17 milímetros, unas medidas muy aceptables (y como muestra de ello tenemos los numerosos proyectos que existen con esta placa) pero aún se puede reducir más.Proyectos como Raspberry Pi Slim indican que el puerto ethernet y los puertos USB “engruesan” mucho a la placa, pudiéndose quitar para reducir aún más las medidas de la placa. Posiblemente Raspberry Pi 4 debería de seguir estos pasos y quitar elementos como el puerto ethernet o sustituir los puertos USB por puertos microusb o usb-c. Intentar tener las medidas de las placas Raspberry Pi Zero y Zero W serían un diseño ideal, esto es, alcanzar 65 x 30 mm sin por ello penalizarse en otras funciones como potencia o comunicaciones.

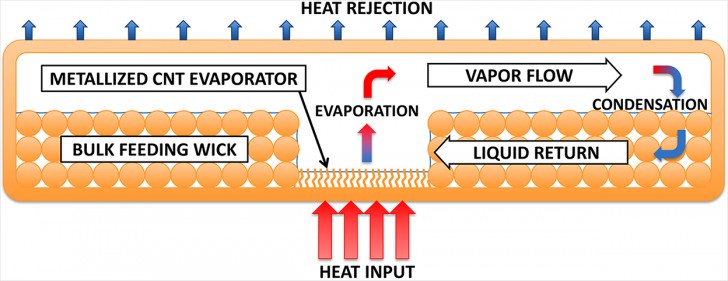

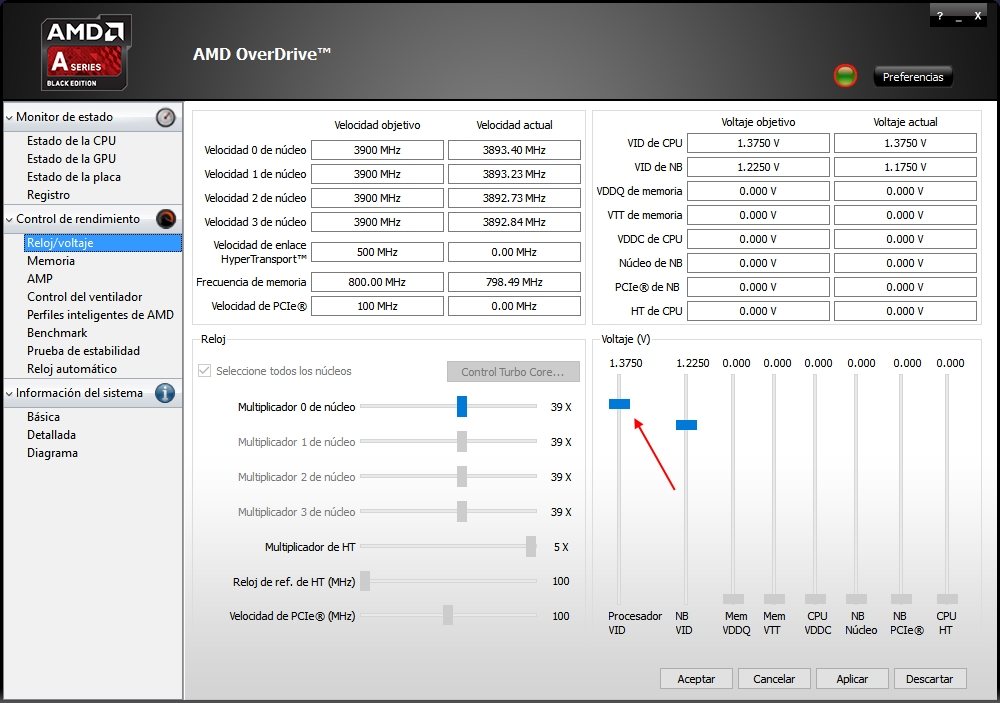

Chipset

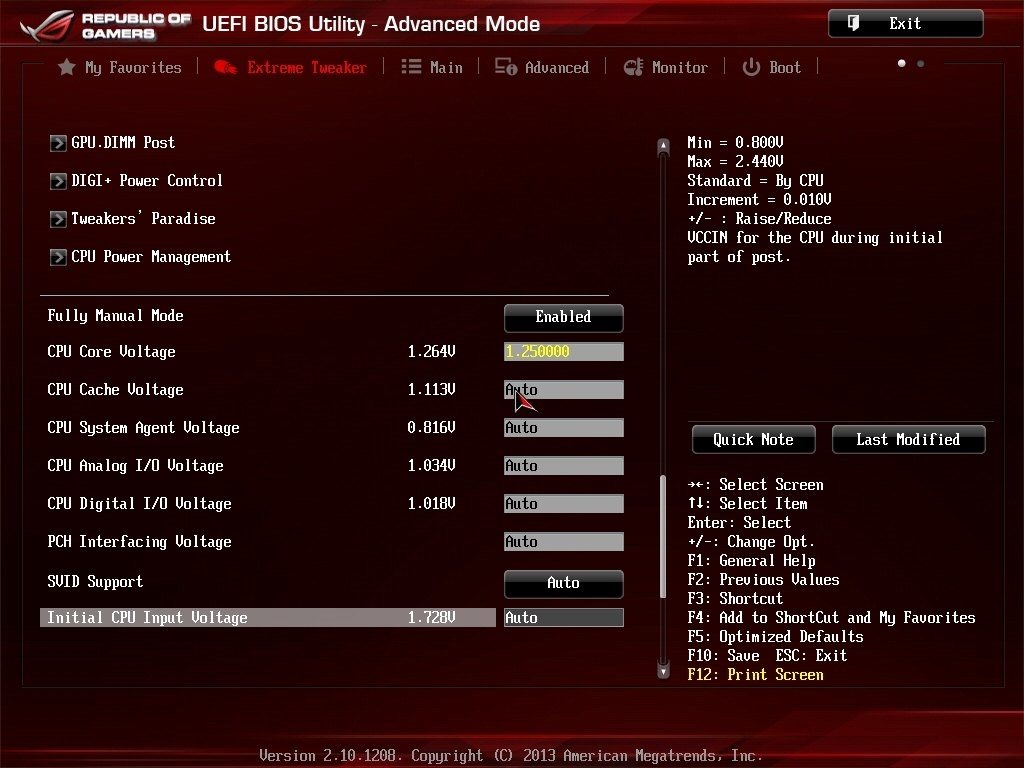

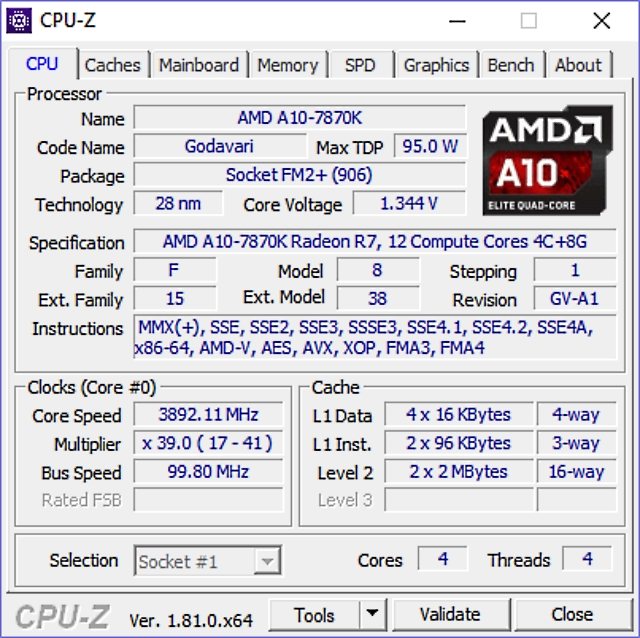

Hablar de chipsets o mejor dicho de futuros chipsets para Raspberry Pi 4 es muy atrevido, pero si que podemos hablar de potencia. Raspberry Pi 3 tiene un SoC Quadcore a 1,2 Ghz, un chip potente pero algo obsoleto si lo comparamos con la potencia de ciertos dispositivos móviles. Por ello, creo que Raspberry Pi 4 debería de tener al menos un chipset con ocho núcleos. Y sin lugar a dudas, separar la GPU de la CPU de la placa. Esto supondrá más potencia para la placa y por extensión poder realizar tareas como el renderizado de imágenes o simplemente ofrecer una mejor resolución en pantallas.Este elemento es el más importante y también reconocemos que el más delicado. Por ello creo que la Fundación Raspberry Pi si que cambiará el chipset en Raspberry Pi 4, ya que las pruebas son lentas y casi obligatorias, justificando así el retraso de la nueva versión.

Almacenamiento

Las últimas versiones de Raspberry Pi han abordado ligeramente el tema del almacenamiento. A pesar de que el almacenamiento principal sigue siendo a través de un puerto microsd, es cierto que se ha incluido la posibilidad de utilizar los puertos USB como unidades de almacenamiento. Muchas placas rivales de Raspberry Pi han incluido módulos de memoria eMMC, un tipo de memoria más rápida y eficaz que los pendrive. Posiblemente, Raspberry Pi 4 debería de tener un módulo de este tipo donde poder instalar software del kernel o poder ser utilizado como memoria swap.Pero el punto más delicado e importante en este aspecto es la memoria ram o mejor dicho cuánta memoria ram debería de tener. Raspberry Pi 3 tiene 1 Gb de memoria RAM, cantidad que acelera bastante las tareas de la placa frambuesa. Pero un poco más estaría mejor. Así, en una futura Raspberry Pi 4, el tener 2 Gb de ram no solo sería importante sino que podría hacer que Raspberry Pi fuese más utilizada aún, llegando a sustituir el ordenador de sobremesa para muchos usuarios.

Comunicaciones

El tema de las comunicaciones es muy importante para placas como Raspberry Pi. Durante las últimas versiones, este tema no ha variado mucho, siendo lo más novedoso la inclusión de un módulo de Wifi y bluetooth. Raspberry Pi 4 debería de plantearse algunas comunicaciones y pensar si ampliar el tipo de comunicaciones o no. Personalmente creo que el puerto ethernet debería de ser eliminado de la placa. Este puerto es muy útil pero también afecta al tamaño de la placa, pudiéndose ser sustituido por el módulo wifi, una tecnología muy madura y extendida por todo el mundo. Además, existen adaptadores de este puerto al puerto usb, por lo que teniendo un puerto USB, podremos tener un puerto ethernet, si realmente necesitamos de este puerto o no podemos tener funcionando el módulo Wifi.El módulo de bluetooth ha supuesto un gran alivio para muchos usuarios, pero la versión 4 de esta placa bien podría ampliar el número de tecnologías inalámbricas, incluyendo la tecnología NFC, una tecnología muy interesante para proyectos IoT. Tener NFC dentro de la placa Raspberry Pi podría ser interesante para emparejar dispositivos y ampliar las funciones de Raspberry Pi, como la conexión con unos altavoces, un smartv, etc… Elementos que actualmente se pueden conectar a Raspberry Pi, pero el NFC facilita aún más la conexión y configuración de estos dispositivos.

El elemento estrella de Raspberry Pi siempre ha sido el puerto GPIO, entre otras cosas por las cientos de funciones y aplicaciones nuevas que este puerto añade a Raspberry Pi. Raspberry Pi 4 podría tratar este elemento y ampliar el puerto GPIO con más pines y por lo tanto poder ofrecer más funciones, funciones soportadas si realmente el chipset utilizado fuera más potente.

Al igual que hemos comentado sobre el puerto ethernet, los puertos USB también podrían ser cambiados y sustituidos por puertos microusb o directamente por puertos USB-C, puertos con una transferencia más alta y con un tamaño más reducido que el tradicional puerto USB. Este cambio no solo permite “adelgazar” el tamaño de Raspberry Pi sino que también da más potencia a la placa, admitiendo velocidades de transferencia más altas que el tradicional puerto USB.

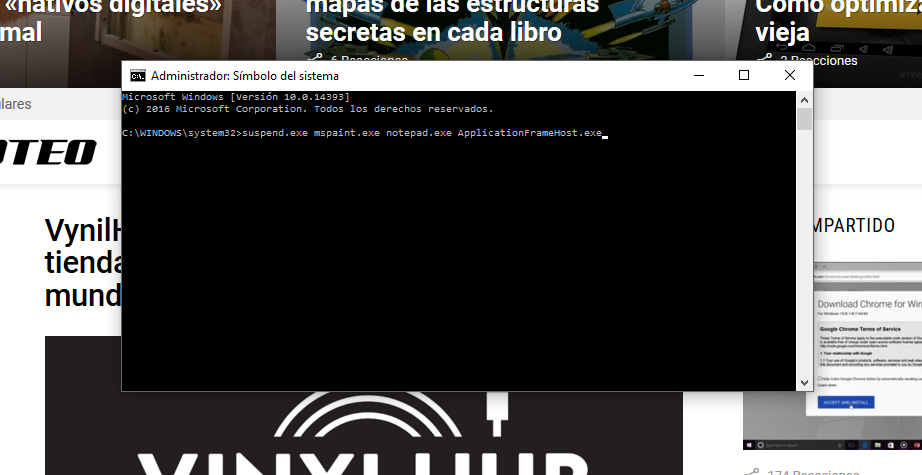

Energía

El aspecto energético es el aspecto en el que está claro que Raspberry Pi debería cambiar para el siguiente modelo de placa. En este aspecto sobresalen dos aspectos: el botón de encendido y la administración de energía que permita utilizar baterías o una entrada con energía más amplia que un puerto microusb. Dos aspectos que Raspberry Pi 4 debería de tener.Es decir, incluir un botón de encendido y apagado, algo que muchos y muchos usuarios demandan y piden para su placa Raspberry Pi. La utilización de un conector específico para la energía también sería importante incluir. Aunque no existe problema de confusión, es cierto que el puerto microusb ofrece poca energía y ello hace que a veces no podamos utilizar toda la potencia de Raspberry Pi por falta de energía.

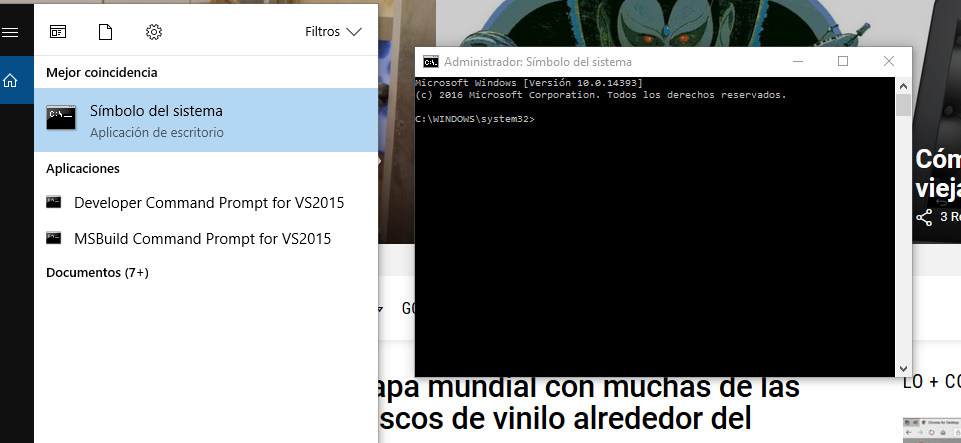

Software

El software es un aspecto muy importante, tal vez el más importante, pues sin software de poco sirve tener el modelo más potente de Raspberry Pi. Si bien es cierto que Raspberry Pi no carece de software, sí que debería de tener entornos más amigables para usuarios novatos. Así, puede que el próximo paso de la Fundación debiera de ser la inclusión de asistentes que ayuden a los más novatos a configurar aspectos de la placa o del funcionamiento de ésta. Siendo Raspberry Pi 4 una placa ideal tanto para usuarios expertos como para usuarios novatos.Conclusión

Hemos hablado mucho de los elementos que Raspberry Pi 4 debería de tener así como de los puntos fuertes y débiles de la placa, pero llegados a este punto voy a dar mi configuración ideal para Raspberry Pi 4.La nueva placa debería de tener una GPU separada, un botón de encendido, eliminar el puerto ethernet y sustituir los puertos usb por puertos microusb. Los 2 Gb de memoria ram estarían bien aunque posiblemente esto encarecería mucho el modelo y sería contraproducente. Al menos esta configuración es la que considero como importante e imprescindible para la próxima versión. Y tú ¿qué crees que debería de tener Raspberry Pi 4?

Fuente:

https://www.hwlibre.com/esperas-raspberry-pi-4/