Probablemente alguna vez hayas sentido curiosidad por ver de cerca o

captar una imagen de ese gorrión que de vez en cuando acude a tu balcón o

terraza en busca de las posibles migas de pan o restos de comida. O del

gato que se pasea por los tejados cercanos en las noches de verano.

Quizás vivas cerca de la naturaleza y desees "cazar" una imagen de la

fauna característica de tu zona.

¿Y si te digo que por menos de 30 euros uno puede conseguir

sentirse un biólogo o como mínimo satisfacer la curiosidad por la fauna

que nos rodea? El proyecto My NatureWatch lleva promoviéndolo desde 2018 con mucho éxito.

Todo comenzó con un programa de televisión de la BBC

SpringWatch

es una estupenda idea de la BBC para acercar la vida salvaje del Reino

Unido a todas las casas. Su primer episodio fue emitido el 30 de mayo de

2005.

Esa primera temporada quedo configurada con 12 episodios que se

emitían en directo con ayuda de hasta 100 cámaras que recorrían

diferentes puntos de la geografía del Reino Unido. El objetivo era mostrar de manera natural la vida salvaje que se abría paso en primavera.

Desde entonces, cada año, en las mismas fechas, alrededor de 3

millones de británicos quedan pegados a las pantallas cuando el directo

de Springwatch arranca en la BBC Two. Durante los doce episodios de cada

temporada, a razón de 3 por semana. Debido a su éxito, la idea del

programa original se ha trasladado a otros momentos del año (otoño e

invierno).

De entre las imágenes que se pueden ver en el programa hay algunas que proceden de cámaras ocultas o espía colocadas en sitios tan peculiares como nidos de aves, madrigueras o jardines.

Uno

de los propósitos del proyecto My Naturewatch es provocar en la gente

curiosidad y respecto por la fauna que la rodea en su entorno más

cercano

Con ese punto de partida en mente, en 2017, miembros del Interaction Research Studio de Goldsmiths (Universidad de Londres) y del programa de diseño de productos del Royal College of Art,

iniciaron conversaciones con el departamento de Historia Natural de la

BBC, que eran los responsable de la creación del programa SpringWatch,

para estudiar maneras de colaborar en el programa.

Su objetivo era conseguir desarrollar un producto que estuviera al

alcance de cualquier ciudadano y que encajara en la idea detrás del

programa: conocer la naturaleza salvaje que nos rodea. En la temporada

de la serie emitida en 2018 el grupo de trabajo dio a conocer su proyecto My Naturewatch, el cual pudieron a disposición de todo el que quisiera sumarse desde casa.

El proyecto, de claro espíritu maker, fue mostrado

en ferias, centros educativos y se llevaron a cabo diferentes acciones

que le otorgaron mucha popularidad. Y ése era precisamente el propósito.

Andy Boucher, codirector del Interaction Research Studio en Goldsmiths, lo define como un proyecto que aspira

a unir el interés por la fauna que rodea a las personas en su entorno

más cercano con el que ya se tiene por la tecnología y la creación de

una comunidad de curiosos de las imágenes que toman las cámaras DIY de otros miembros del proyecto.

De hecho, el proyecto, no se ha detenido aquí. Se ha asociado a un

programa de seguimiento de pequeñas aves que habitualmente encontramos

en jardines de casas particulares y que con ayuda de tecnología RFID en

sus anillas de identificación, se pueden mantener en seguimiento usando

comederos que leen esas etiquetas.

Pero lo mejor del proyecto es que, hoy en día, cualquiera con cierto

interés, curiosidad y una Raspberry Pi puede construirse su propia cámara espía de la naturaleza.

Cómo construir tu propia cámara espía de la naturaleza con el proyecto MyNaturewatch

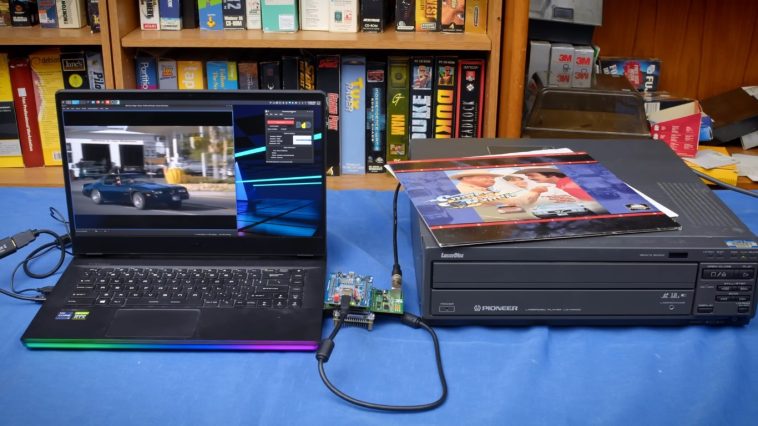

My Naturewatch es un sistema integral DIY que usa

cámaras básicas para, con ayuda de algoritmos de detección de movimiento

y visión computerizada, capturar automáticamente imágenes de animales

que pasan por delante de la cámara.

El sistema es una recreación muy básica y asequible de los sistemas

de cámaras ocultas que se usan en documentales o por biólogos y

profesionales. El proyecto incluye desde las instrucciones para poner en

marcha el sistema al software necesario o consejos sobre dónde

colocarlas y camuflarlas.

Elementos del sistema My NatureWatch

El sistema básico puede conseguirse por unos pocos euros, alrededor

de los 30. El mayor coste lo supone la Raspberry Pi correspondiente así

como la cámara. El resto es básicamente hasta donde queramos llegar con

nuestro sistema DIY.

My Naturewatch puede ser configurada en una Raspberry Pi Zero W , Pi 3A+, Pi 3B+ o Pi 4B. Lo ideal, por tamaño y consumo, es optar por el modelo Zero. Pero en cualquiera de ellas funciona perfectamente.

Junto con la Raspberry Pi que escojamos solo necesitamos como componentes principales los siguientes:

- Tarjeta microSD de no más de 64 GB preferiblemente.

- Módulo de cámara para Raspberry Pi (desde 15 euros).

- Algún disipador para la Raspberry Pi si no tenemos una carcasa que lo incluya.

- Batería de tipo Power Bank.

El resto de elementos ya dependerán del diseño que queramos hacer

para el "contenedor" del sistema, que deberá ser estanco para evitar que

el sistema se estropee por el agua, pues la idea principal es que quede

al aire libre por periodos largos de tiempo.

Pasos a seguir para la construcción y puesta en marcha

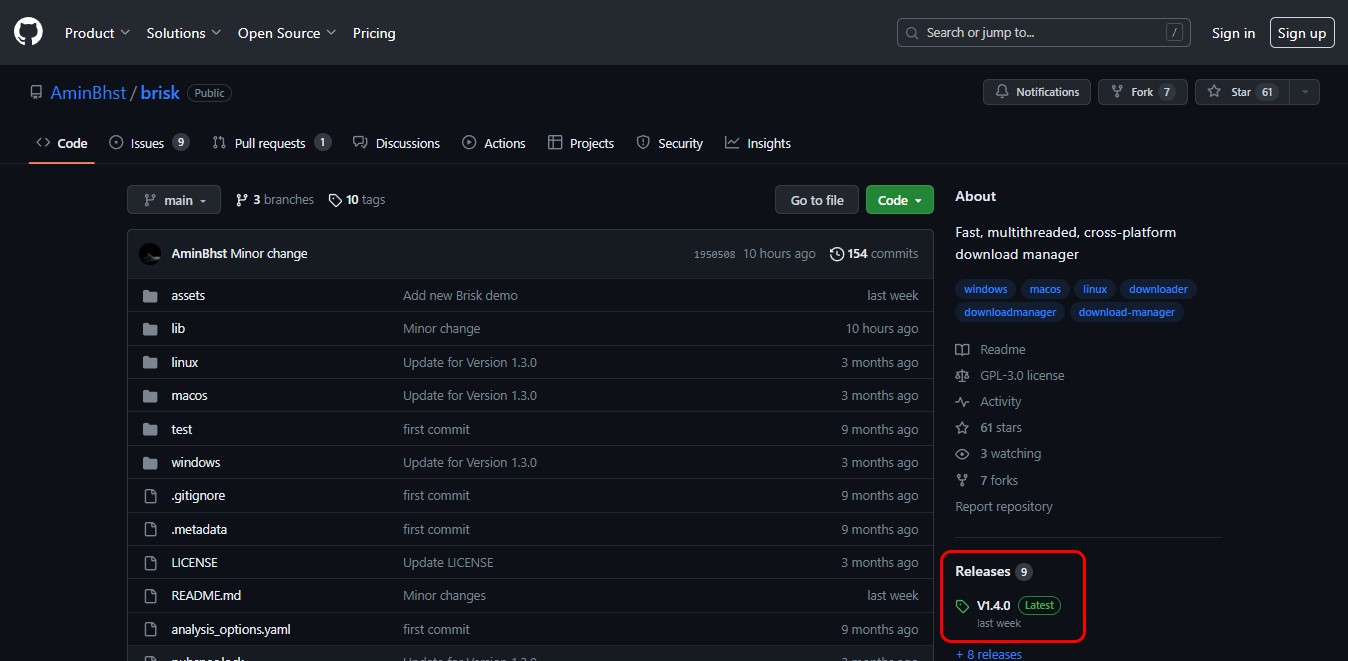

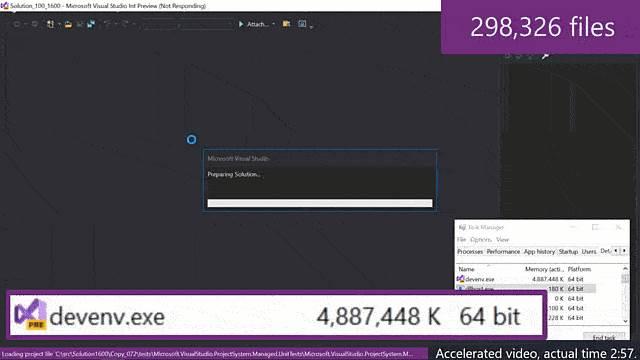

Algo que debes tener en cuenta antes de empezar el proyecto es que la Raspberry Pi tendrá que ejecutar una distribución exclusiva

que el proyecto My NatureWatch ha desarrollado para este propósito

(básicamente un servidor con unas pocas funciones extras). Hacerlo es

tan sencillo como con cualquier otra distribución que se instala en una

RPi.

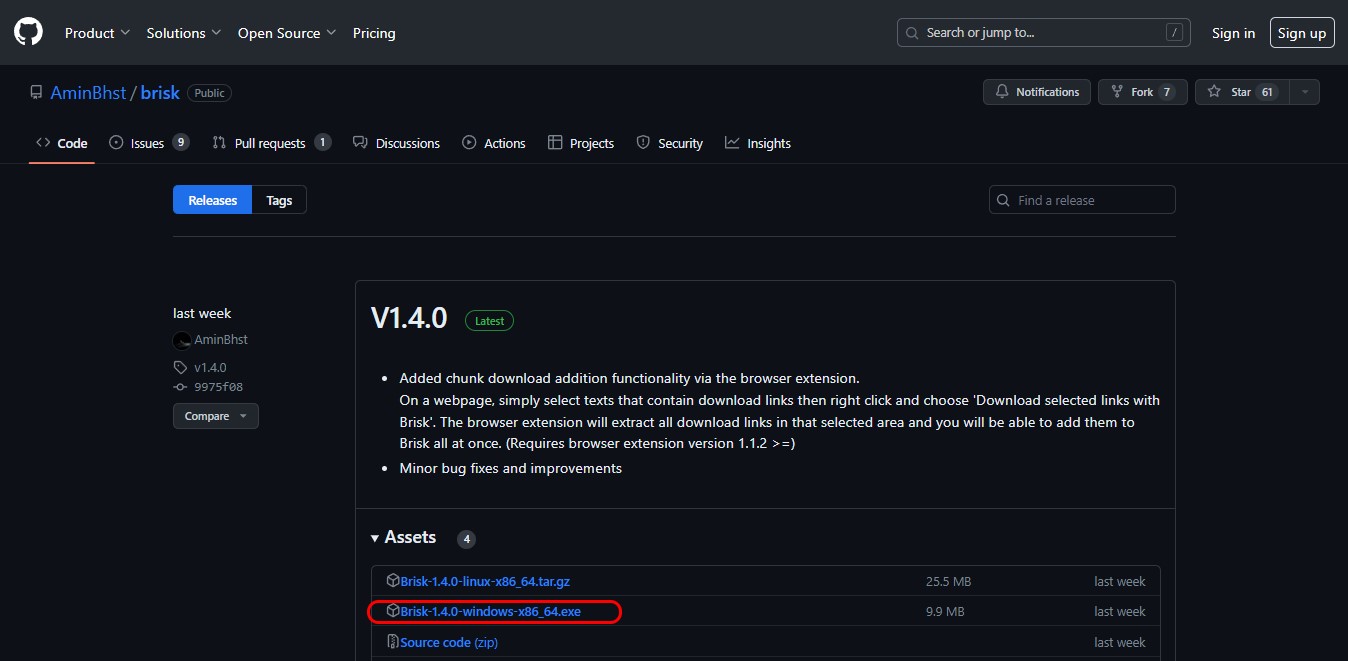

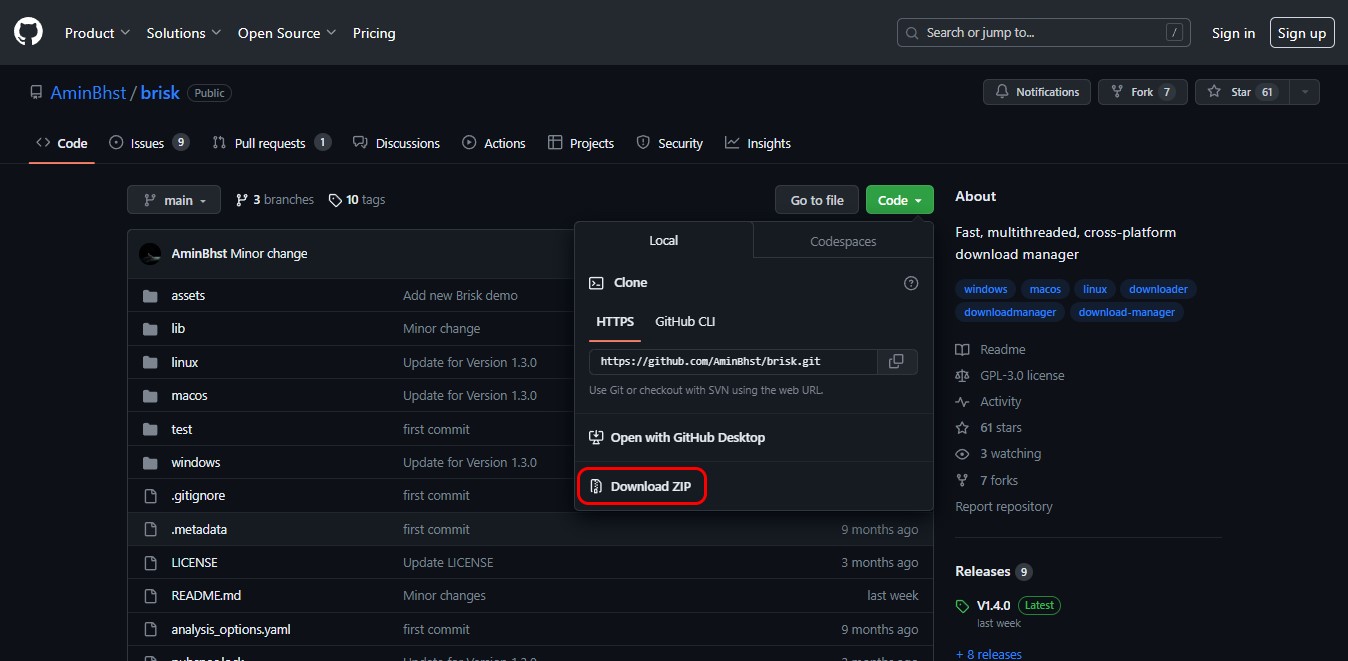

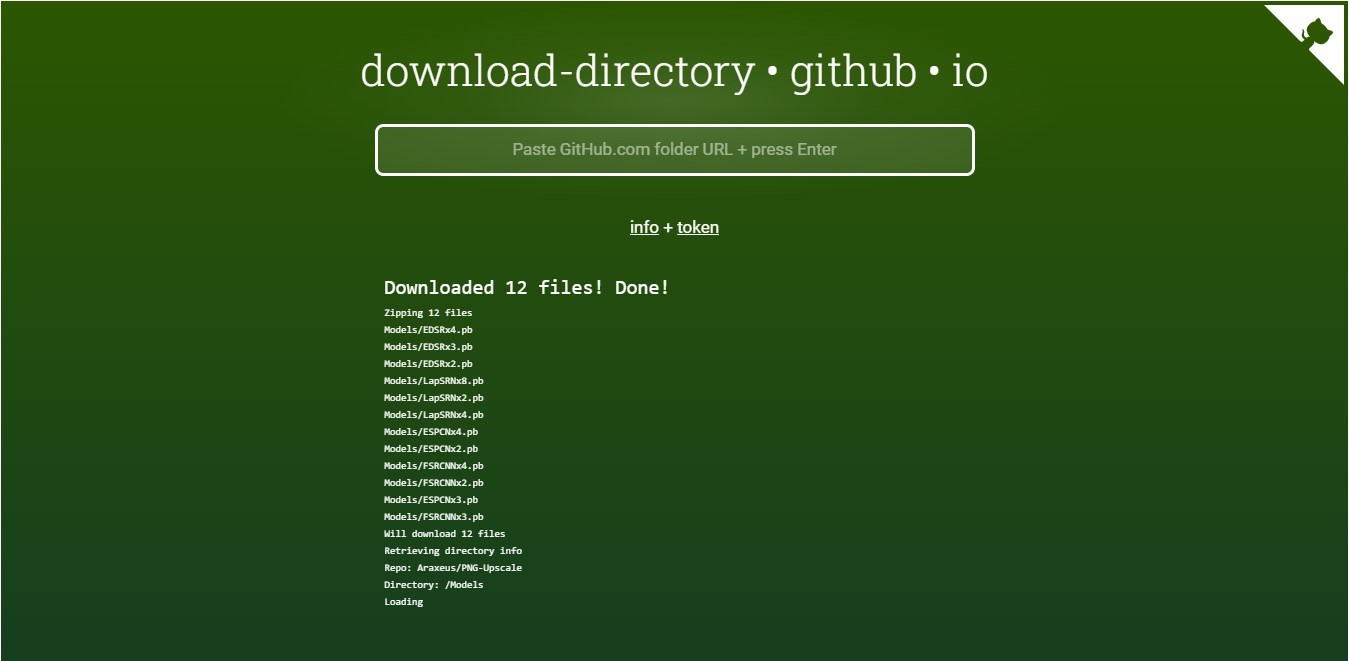

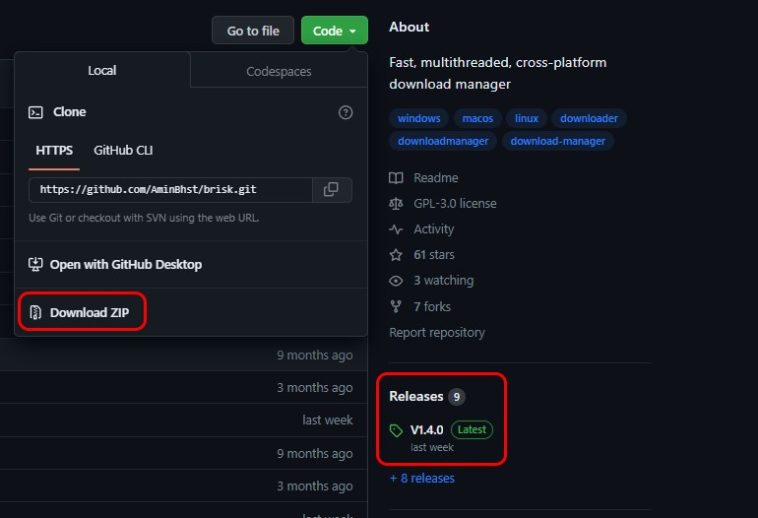

Nos descargamos en primer lugar la imagen de la distribución y posteriormente el software gratuito Etcher,

con el cual vamos a grabar la imagen de la distribución en la tarjeta

microSD. El proyecto advierte de que puede dar problemas con capacidades

de más de 64 GB. Nosotros lo hemos realizado con una de 16 GB sin

problemas.

A continuación insertaremos la tarjeta microSD en la Raspberry Pi y,

conectada a la alimentación (la batería externa, por ejemplo), se

iniciará el servidor de My Naturewatch. Pasamos unos segundos ya

podremos pasar a configurar el sistema.

Para hacerlo debemos conectarnos desde un ordenador o smartphone a la red Wifi que crea el software en la Raspberry Pi,

del tipo MyNaturewatch-123456. La numeración será generada de manera

automática y diferente por cada distribución. La contraseña es

'badgersandfoxes'.

Lo siguiente será ir a la dirección 192.168.50.1 usando un navegador y nos aparecerá la sencilla interfaz de My Naturewatch.

Interfaz de la versión web en ordenador

Interfaz de la versión web en ordenador Allí, además de ver en directo lo que registra la cámara, podemos

iniciar la función de grabación de vídeo de toma de imágenes, las cuales

quedarán registradas en la galería de la aplicación. Las imágenes o el

vídeo solo se empiezan a registra cuando se detecta movimiento delante

de la cámara.

El resto de opciones son igual de sencillas y permiten desde variar

la orientación de la imagen a la sensibilidad del detector de movimiento

o la exposición automática.

Esta configuración básica limita el acceso a la cámara cuando estamos

dentro del alcance de la red Wifi creada por la Raspberry Pi. En caso

de que queramos acceder a ella desde cualquier sitio con red debemos modificar algunos archivos de la distribución para hacer que se conecte directamente a Internet.

La parte divertida: construir tu propia carcasa

Aunque desde el proyecto My Naturewatch dan consejos

para construir una carcasa y protección para la cámara, una vez

configurada la distribución llega la parte maker en la que pensar y

construir nuestra propia carcasa.

Aquí es recomendable en primer lugar fijar la Raspberry Pi y cámara a

un cartón o elemento rígido, el cual luego ya debemos introducir en un

lugar estanco pues dentro deberá quedar, además de la propia RPi, la

batería externa que alimentará el miniordenador. En el proyecto que

nosotros hemos montado, una batería de 5000 mAh nos dio para toda una mañana de vigilancia, alrededor de las 8 horas.

El último paso ya es solo disfrutar y pensar en qué rincones cerca de

casa, el patio, una excursión con recorrido circular o las zonas que se

nos ocurran, podemos dejar bien camuflada nuestra cámara espía My

Naturewatch y sentirnos un poco Rodriguez De la Fuente de la fauna que

nos rodea.

Fuente:

https://www.xataka.com/especiales/my-naturewatch-camara-espia-naturaleza-que-puedes-construir-tu-raspberry-pi