FAT32 es uno de los sistemas de archivos más utilizados en unidades externas/extraíbles por su simplicidad y versatilidad. Una mejora del antiguo FAT creado para MS-DOS y usado en ediciones de consumo de Windows hasta Windows Me, soportado además en otros sistemas como GNU/Linux, FreeBSD y BeOS.

Aunque hay sistemas de archivos más avanzados en Windows (exFAT o NTFS), FAT32 sigue utilizándose en múltiples formatos por las ventajas mencionadas de soporte y portabilidad. El problema es que la herramienta estándar presente en Windows no puede formatear discos externos FAT32 con capacidades mayores a 32 TB, aunque sí puede manejarlos porque su límite teórico sube hasta 16 TB.

FAT32 con herramientas de terceros

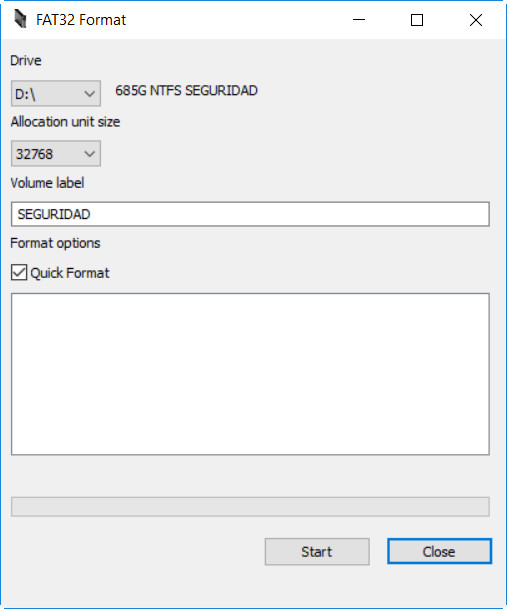

Si tienes discos duros externos, pendrives USB o tarjetas microSD con capacidades de 64 GB o superiores, y quieres utilizar FAT32, hay herramientas de terceros que puedes utilizar para salvar la limitación de la herramienta estándar de Windows.Una de ellas es FAT32 Format. Una aplicación gratuita y portable que no necesita instalación y facilita la tareas de formatear unidades FAT32 con capacidad superior a los 32 GB. Simplemente: descarga (botón Start del enlace), ejecuta, selecciona la unidad, activa el formateo rápido e inicia.

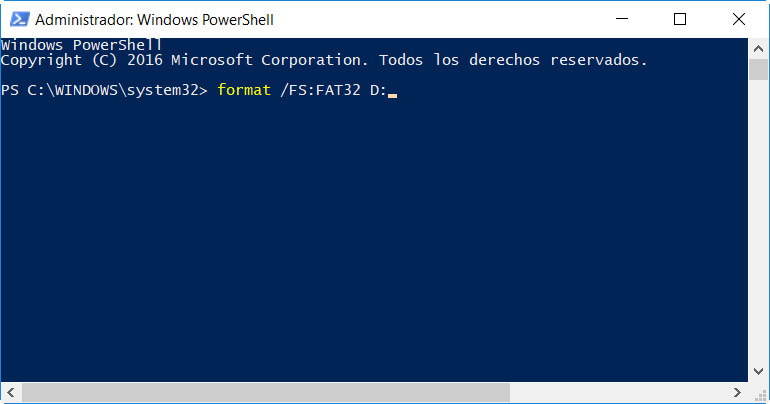

FAT32 con Powershell

La aplicación anterior es la recomendada por facilidad de uso y rapidez de ejecución, pero si quieres utilizar el mismo Windows hay otro método que salva la limitación de la herramienta de formateo estándar. Simplemente accede y usa el comando “format /FS:FAT32 X:” donde “X” es la unidad que queremos formatear:

La consola tarda bastante más tiempo en realizar el formateo por lo que te recomendamos el uso de FAT32 Format. En ambos casos recuerda que el manejo de archivos individuales en FAT 32 es de 4 Gbytes. El límite teórico de la capacidad de la unidad con este tipo de sistema de archivos es de 16 TB, sobrado para toda la base de dispositivos en el mercado.

Fuente:

http://www.muycomputer.com/2017/08/14/fat32/